PYTANIA: Czy częstotliwość kliknięć ma znaczenie?

Czy budując pozycję, na przykład w przypadku wyszukiwarki lub systemu rekomendacji, warto polegać na częstotliwości kliknięć w celu ustalenia trafności wpisu?

ODPOWIEDZI

Ze swojej strony mogę powiedzieć, że używam częstotliwości kliknięć np. W produktach eCommerce. Jeśli połączysz go z dniami roku, może on nawet przynieść wspaniałe sugestie. tj .: mamy dane historyczne z 1 roku dla 2 produktów (Snowboots [], Sandalettes [])

Snowboots [1024,1253,652,123,50,12,8,4,50,148,345,896]

Sandały [23,50,73,100,534,701,1053,1503,1125,453,213,25]

gdzie [0] = styczeń

Jak widać, snowbooty są częściej wyszukiwane w styczniu niż sandały, więc powinieneś zasugerować snowboots komuś, kto szuka butów na twojej stronie lub w styczniu. Możesz również sprawdzić, czy coś jest „świeże” w tej chwili, np. Kiedy ludzie często klikają nieznany produkt, może to być wgląd w nowy trend lub coś takiego. To tylko kilka przykładów, w których możesz wykorzystać częstotliwość kliknięć jako wgląd. Myślę, że nie ma żadnych zasad dotyczących tego, czego można użyć w zaleceniach, o ile ma to sens.

Czy można użyć częstotliwości kliknięcia, a następnie tak. Czy można używać tylko częstotliwości kliknięć, a następnie prawdopodobnie nie. Trafność wyszukiwania jest znacznie bardziej skomplikowana niż tylko jedna metryka. Istnieją całe książki na ten temat. Rozszerzenie tej odpowiedzi poza zwykłe tak / nie spowodowałoby, że odpowiedź byłaby zdecydowanie zbyt szeroka (i wyrażona w opinii)

Jak należy obchodzić się z danymi niejawnymi w zaleceniu?

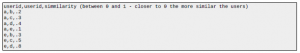

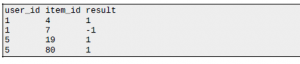

System rekomendacji prowadzi dziennik tego, jakie rekomendacje zostały wydane konkretnemu użytkownikowi i czy ten użytkownik je przyjmuje. To jest jak

gdzie 1 oznacza, że użytkownik zaakceptował zalecenie, a -1 oznacza, że użytkownik nie odpowiedział na zalecenie.

Jeśli mam zamiar wydać zalecenia dla grupy użytkowników na podstawie dziennika opisanego powyżej i chcę zmaksymalizować wyniki MAP @ 3, jak powinienem postępować z niejawnymi danymi (1 lub -1)?

Moim pomysłem jest traktowanie 1 i -1 jako ocen i przewidywanie oceny za pomocą algorytmów typu maszynowego rozkładania na czynniki. Nie wydaje się to jednak właściwe, biorąc pod uwagę asymetrię niejawnych danych (-1 nie oznacza, że użytkownikowi nie podoba się to zalecenie).

Edycja : Pomyślmy o tym w kontekście metody faktoryzacji macierzy. Jeśli traktujemy -1 i 1 jako oceny, będzie jakiś problem. Na przykład użytkownik 1 lubi film A, który osiąga wysokie wyniki w jednym współczynniku (np. Mając wspaniałą muzykę w tle) w przestrzeni ukrytego czynnika. System zaleca film B, który również osiąga wysokie wyniki w „chwalebnej muzyce w tle”, ale z jakiegoś powodu użytkownik 1 jest zbyt zajęty, aby przyjrzeć się rekomendacji, i mamy film kategorii -1 B. Jeśli po prostu traktujemy 1 lub -1 jednakowo , wtedy system może być zniechęcony do polecania filmu z chwalebnym BGM użytkownikowi 1, podczas gdy użytkownik 1 nadal uwielbia film z chwalebnym BGM. Myślę, że takiej sytuacji należy unikać.

Twój system nie jest tylko przeszkolony w zakresie przedmiotów polecanych, prawda? jeśli tak, masz dużą pętlę sprzężenia zwrotnego. Mam nadzieję, że chcesz uczyć się na podstawie wszystkich kliknięć / wyświetleń. Sugerujesz, że nie patrzenie na przedmiot jest sygnałem negatywnym. Zdecydowanie sugeruję, abyś nie traktował tego w ten sposób. Brak interakcji z czymś jest prawie zawsze najlepiej traktowany jako brak informacji. Jeśli masz wyraźny sygnał, który wskazuje na niechęć, na przykład głosowanie w dół (lub może obejrzałeś 10 sekund filmu i zatrzymał się), być może jest to poprawne. Nie interpretowałbym tych danych wejściowych jako danych podobnych do ratingu. (Chociaż w twoim przypadku możesz uciec od tego.) Zamiast tego pomyśl o nich jak o wadze. Pozwala to zarejestrować względną siłę interakcji dodatnich / ujemnych. Na koniec chciałbym zauważyć, że ten artykuł, chociaż jest prawdopodobnie tym, czego szukasz, nie przewiduje ujemnych wag. W ten sposób można go łatwo rozszerzyć. Jeśli dojdziesz tak daleko, mogę wskazać łatwe rozszerzenie, które już istnieje w dwóch znanych mi implementacjach, w Spark i Oryx.

Utwórz najbardziej „średnią” obserwację podobieństwa cosinus

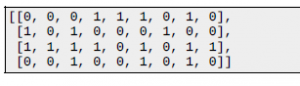

W systemie rekomendacji używam podobieństwa cosinus do obliczania podobieństw między elementami. Jednak w przypadku przedmiotów z niewielką ilością danych chciałbym podzielić je na kategorie w kategorii „przeciętnej” (w sensie ogólnym nie matematycznym). Aby to osiągnąć, próbuję obecnie utworzyć syntetyczną obserwację reprezentującą ten środek punktu drogi. Na przykład, jeśli były to moje obserwacje (wiersze to obserwacje s, cols to cechy):

Strategia, w której po prostu brałam rzeczywistą średnią wszystkich cech z obserwacji, generowałaby syntetyczny punkt danych, taki jak poniżej, który następnie dołączałam do macierzy przed obliczeniem podobieństwa.

[0,5, 0,25, 0,75, 0,5, 0,25, 0,75, 0,25, 0,75, 0,25]

Chociaż może to działać dobrze w przypadku niektórych wskaźników podobieństwa (np. Odległość L1), jestem pewien, że istnieją znacznie lepsze sposoby na podobieństwo cosinus. Chociaż w tej chwili mam problem z wytłumaczeniem kątów między liniami w przestrzeni o dużych wymiarach. Jakieś pomysły?

Robisz właściwą rzecz. Technicznie to uśrednianie prowadzi do obliczenia środka ciężkości w przestrzeni euklidesowej zbioru N punktów. Środek ciężkości działa całkiem dobrze z podobieństwami cosinusa (cosinus kątów między znormalizowanymi wektorami), np. algorytm Rocchio.

Optymalizacja cen produktów wielopoziomowych i sezonowych

Zakładając, że mogę zaspokoić zapotrzebowanie na zakup określonego produktu o różnych poziomach rynkowych. Przykład: Produkt A to towary niskiej jakości. Produkt B to kolejne towary niskiej jakości. Produkty C i D są towarami średniego poziomu, a produkty E i F są towarami wysokiego poziomu. W zeszłym roku zebraliśmy dane dotyczące następujących 1. Którego okresu (sezon – świąteczny? Nie świąteczny?) Reaguje inny produkt poziomu na podstawie ustalonej ceny? Reakcje odnoszą się do tego, ile% produktu jest sprzedawane w określonym przedziale cenowym 2. Jak szybko reaguje rynek po zakończeniu marketingu? Marketing odbywa się w dniu 10 czerwca, a wszystkie produkty są sprzedawane do 18 czerwca w okresie świątecznym, który miał się wydarzyć w lipcu (zajęło 8 dni w tej cenie, aby zakończyć sprzedaż). Jak nauka danych może skorzystać na poleceniu 1. Jeśli powinniśmy naciskać marketing wcześniej czy później? 2. Czy możemy podwyższyć lub obniżyć cenę? (W oparciu o popyt i stopę zamknięcia?) Czy rozumiem, że analiza danych może pomóc marketerowi w tym aspekcie? W którym kierunku powinienem patrzeć, jeśli chcę się o tym dowiedzieć.

Powinieneś być w stanie zastosować regresję liniową, aby znaleźć korelację między czynnikami, które powodują, że Twoje produkty sprzedają się lepiej (lub gorzej). Istnieje wiele korelacji, z którymi można przetestować w tym zestawie danych. Oto niektóre przykłady:

- Jeśli produkt został agresywnie wprowadzony na rynek, czy sprzedaje się szybciej?

- Jeśli dostępny jest przedmiot niskiego poziomu, czy sprzedaje się mniej przedmiotów wyższego poziomu?

- Jeśli dostępnych jest wiele przedmiotów wyższego poziomu, czy ich liczba jest mniej sprzedawana?

Pamiętaj, że korelacja niekoniecznie oznacza związek przyczynowy. Zawsze myśl o innych czynnikach, które mogą powodować wzrost i spadek sprzedaży. Na przykład możesz sprzedawać więcej przedmiotów na wyższym poziomie w sezonie o rok niż w innym. Ale może to wynikać ze zmian w całej gospodarce, a nie ze zmian cen. Drugą rzeczą, którą możesz zrobić, to przeprowadzić testy A / B na stronach sprzedaży produktów. To zapewnia natychmiastową informację zwrotną. Niektóre przykładowe testy mogą być:

- Pokaż użytkownikowi jeden produkt wysokiego poziomu i jeden produkt niskiego poziomu (A). Pokaż użytkownikowi dwa produkty wysokiego poziomu i brak produktów niskiego poziomu (B). Która strona generuje większe przychody?

- Wysyłaj e-maile marketingowe dotyczące sprzedaży sezonowej z 5-dniowym wyprzedzeniem do jednej grupy użytkowników (A). Wyślij ten sam e-mail do innego zestawu użytkowników z jednodniowym wyprzedzeniem (B). Istnieje wiele możliwości. Wykorzystaj swoją intuicję i pomyśl o wcześniejszej wiedzy na temat swoich produktów.