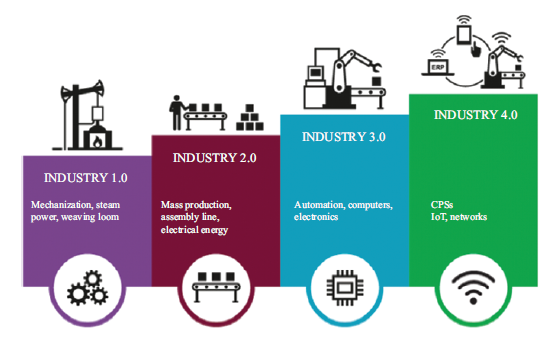

Przemysł 4.0 to strategiczna inicjatywa wprowadzona przez rząd niemiecki na początku 2010 roku w celu przekształcenia produkcji przemysłowej poprzez cyfryzację i wykorzystanie potencjału nowych technologii. Jest to próba zwiększenia produktywności i efektywności głównie w sektorze produkcyjnym. System produkcyjny Przemysłu 4.0 ma być wysoce elastyczny i powinien być w stanie wytwarzać zindywidualizowane i niestandardowe produkty. W rzeczywistości jest to ekscytujące zastosowanie automatyzacji w produkcji, obejmujące wykorzystanie robotyki, zarządzanie danymi, przetwarzanie w chmurze i Internet rzeczy (IoT). Zaczęto pokazywać, że sztuczna inteligencja, robotyka, inteligentne czujniki i zintegrowane systemy są ważną częścią normalnego procesu produkcyjnego. We współpracy z maszynami wymaga integracji poziomej na każdym etapie procesu produkcyjnego. Amerykanie mają tę samą koncepcję dla Przemysłu 4.0, ale wolą nazywać to Smart Factory. Przemysł 4.0 dostarczył wiele emocji i wiele osób z różnych branż decyduje się obecnie na to, jak się zaangażować. Wiele osób uważa, że Przemysł 4.0 to w rzeczywistości przepakowywanie i łączenie różnych kluczowych technologii i technologii, które już istniały. Odświeżono akceptację, dostarczając całościową owijkę, która zapewnia pełną funkcjonalność, która zasadniczo obejmuje zadania związane z gromadzeniem dużych zbiorów danych, przetwarzaniem i analizowaniem danych oraz ulepszaniem procesu dzięki pozytywnym informacjom zwrotnym w celu zwiększenia funkcjonalności i wydajności. W pierwszej rewolucji przemysłowej nastąpiło drastyczne przejście od pracy fizycznej do silnika parowego. Była to epoka, w której wykorzystano mechaniczną przewagę maszyn parowych, aby zmniejszyć zależność od wykorzystania ludzkiej pracy. Po niej nastąpiła druga rewolucja przemysłowa, która wykorzystała moc elektryczności. Silniki parowe zostały wycofane przez wprowadzenie silników elektrycznych i systemów analogowych. W tym okresie wszechobecnie budowano linie montażowe do produkcji masowej. Tymczasem Trzecia Rewolucja Przemysłowa skupiła się na automatyzacji pracy. Komputery i systemy elektroniczne były szeroko stosowane w fabrykach i poza nimi. Czwarta rewolucja przemysłowa, powszechnie nazywana IR 4.0, opiera się głównie na integracji danych, sztucznej inteligencji, maszynach przemysłowych i komunikacji w celu stworzenia wysoce wydajnego, zautomatyzowanego i inteligentnego ekosystemu przemysłowego. Industry 4.0 jest podzbiorem IR4.0, który obejmuje przyszły stan przemysłu charakteryzujący się całkowitą cyfryzacją przepływów produkcyjnych. Przemysł 4.0 obejmuje sześć głównych zasad, tj. interoperacyjność, wirtualizację, decentralizację, możliwości w czasie rzeczywistym, orientację na usługi i modułowość. Interoperacyjność umożliwia systemom cyberfizycznym, ludziom i fabrykom skuteczne łączenie się i komunikowanie się ze sobą za pośrednictwem Internetu Rzeczy i Internetu usług (IoS). Wirtualizacja zapewnia wirtualną kopię fabryki, która powstaje poprzez połączenie danych z czujników z wirtualnymi modelami zakładów i modelami symulacyjnymi. Decentralizacja to zdolność systemów cyberfizycznych z fabrykami do samodzielnego podejmowania optymalnych decyzji. Możliwości w czasie rzeczywistym są niezwykle istotne, ponieważ pomagają zbierać i analizować zebrane dane oraz natychmiast generować spostrzeżenia. Poza tym, aby spełnić zasadę zorientowania na usługi, musi oferować usługi systemów cyber-fizycznych, człowieka i fabryk za pośrednictwem IoS. Dzięki zasadzie modułowości posiada elastyczność w dostosowywaniu inteligentnych fabryk do zmieniających się wymagań poszczególnych modułów. Industry 4.0 to przełomowa koncepcja, która rewolucjonizuje sposób wydajnej produkcji produktów i tworzy nową generację przemysłowych systemów produkcyjnych, które będą całkowicie różne od istniejących. Wdrożenie wszystkich tych możliwości w fabrykach to dopiero początek. Muszą być w stanie bezproblemowo i wzajemnie współpracować w środowisku produkcyjnym, aby można je było zaliczyć do Przemysłu 4.0. Co ważne, Przemysł 4.0 determinuje przyszły stan przemysłu charakteryzujący się cyfryzacją przepływów produkcji i jest ekscytującym przełomem, ponieważ innowacje towarzyszą zrównoważonym procesom. Ponieważ produkcja przemysłowa jest silnie napędzana przez globalną konkurencję i szybko zmieniające się wymagania rynku, ekstremalne postępy w obecnych technologiach produkcyjnych mogą je tylko spełnić. Wprowadzenie Przemysłu 4.0 jest zatem aktualne i ważne dla zapewnienia zrównoważonego rozwoju działalności produkcyjnej. Jest to obiecująca koncepcja oparta na integracji procesów produkcyjnych i biznesowych oraz integracji wszystkich interesariuszy biznesowych w łańcuchu wartości, czyli dostawców i klientów.

Przemysł 4.0

Przemysł 4.0: kolejna granica i jej wpływ technologiczny, rola globalnej normalizacji i zrównoważonego rozwoju

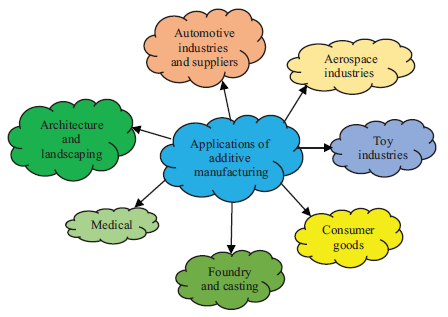

Czwarta rewolucja przemysłowa lub Przemysł 4.0 obejmuje branże oparte na produkcji, łączące zaawansowane techniki produkcji z transformacją cyfrową, napędzane przez technologie połączone w celu stworzenia inteligentnych systemów produkcyjnych, które nie tylko są ze sobą połączone, ale także mają zdolność komunikowania się, analizowania, prognozowania i wykorzystywania te informacje w celu prowadzenia dalszych inteligentnych działań. Nowe modele biznesowe i technologie, takie jak internet rzeczy (IoT), big data, sztuczna inteligencja (AI) (dokładna diagnoza w systemach opieki zdrowotnej, analiza danych rynkowych i finansowych, autonomiczne samochody itp.) oraz produkcja addytywna (lotnictwo i produkcja komponentów motoryzacyjnych, biokompatybilne materiały do niestandardowych implantów, urządzenia ratujące życie w sektorze medycznym, wydajna i przyjazna dla środowiska produkcja komponentów dla sektora energetycznego i energetycznego itp.) napędzają zmiany obecnych modeli biznesowych oraz zmiany globalnej ekonomii i struktur rynkowych. Według McKinsey, Industry 4.0: Reinvigorating ASEANManufacturing for the Future, Industry 4.0 ma przynieść globalnie od 1,2 do 3,7 bln USD zysków. Z tego Stowarzyszenie Narodów Azji Południowo-Wschodniej (ASEAN), którego gospodarki członkowskie spośród 10 krajów mają znaczące gospodarki oparte na produkcji, ma potencjał do wykorzystania dużych możliwości i wzrostu wydajności o wartości od 216 do 627 mld USD.

Globalna standaryzacja w Przemyśle 4.0

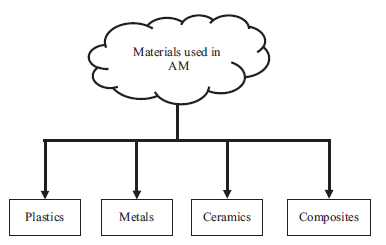

Przemysł 4.0 otwiera drzwi do łączności, innowacyjności i siły ekonomicznej, pozwalając firmom być bardziej elastycznym, wydajnym i oszczędzającym zasoby . Kluczowym składnikiem tej cyfrowej rewolucji są dane. Wydajne wykorzystanie przetwarzania surowych danych w znaczące informacje jest niezbędnym czynnikiem umożliwiającym przyszłe biznesy. Aby nadążyć za postępem Przemysłu 4.0 i przejściem do tej nowej ery, sektor produkcyjny musi na przykład przejść transformację cyfrową z wbudowanymi czujnikami w sprzęcie produkcyjnym i komponentach produktów, automatyzacją, wszechobecnymi systemami cyberfizycznymi i analizą wszystkich odpowiednie dane i informacje. Transformacje te są napędzane przez cztery główne klastry przełomowych technologii i czynników, a mianowicie dane, moc obliczeniowa i łączność; analityka i sztuczna inteligencja; interakcja człowiek-maszyna zarządzana przez interfejsy dotykowe i rzeczywistość rozszerzoną (AR) oraz konwersję cyfrowo-fizyczną, w której pojawia się zaawansowana robotyka i druk 3D . Tymczasem sektor energetyczny musi skoncentrować się na nadchodzących technologiach energetycznych, standaryzacji technologii wysokiego poziomu i szybkich prędkości z fuzją i konwergencją technologii informacyjno-komunikacyjnych (ICT), inteligentnymi i inteligentnymi sieciami energetycznymi, systemami magazynowania energii, dużymi danymi, sztuczną inteligencją i cyberbezpieczeństwo. Sektor energetyczny jest infrastrukturą krytyczną. Dlatego niezbędne jest zapewnienie sprawnego i ciągłego zasilania.

Szerokie zastosowanie nowych i zaawansowanych technologii wymaga inteligentnego systemu integracji, który można osiągnąć tylko wtedy, gdy odpowiednie technologie, interfejsy, ramy i formaty są zgodne z ogólnie przyjętymi standardami. Warunkiem interoperacyjności w środowisku Przemysłu 4.0 są międzynarodowe i akceptowane normy i standardy. Dlatego Przemysł 4.0 i standaryzacja muszą iść w parze.

Przemysł 4.0 wiąże się z globalną transformacją gospodarczą. Dlatego też krajowe działania normalizacyjne muszą być zharmonizowane z poziomem międzynarodowym, aby skoncentrować się na określeniu mechanizmów współpracy międzynarodowej i współpracy oraz wymiany informacji. Skupienie się na Przemyśle 4.0 wymaga skoordynowanych i skoordynowanych działań wszystkich odpowiednich interesariuszy oraz ministerstw i agencji rządowych, aby poprowadzić krajową transformację do Przemysłu 4.0 poprzez finansowanie i zachęty, talenty i kapitał ludzki, technologię i standardy oraz infrastrukturę cyfrową i ekosystem.

Technologiczny wpływ Przemysłu 4.0

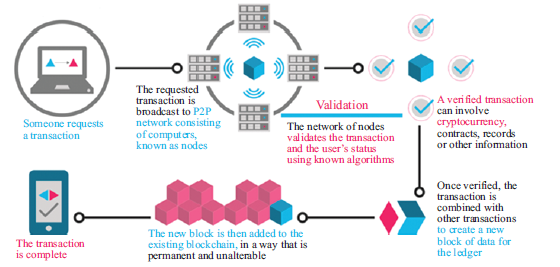

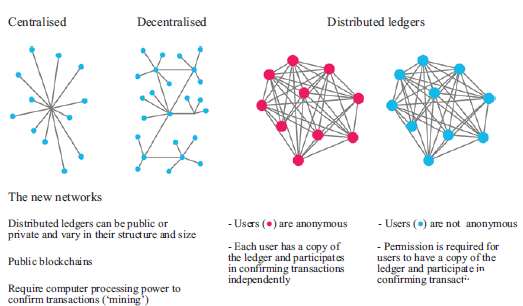

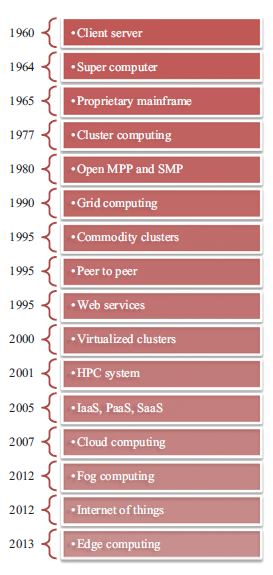

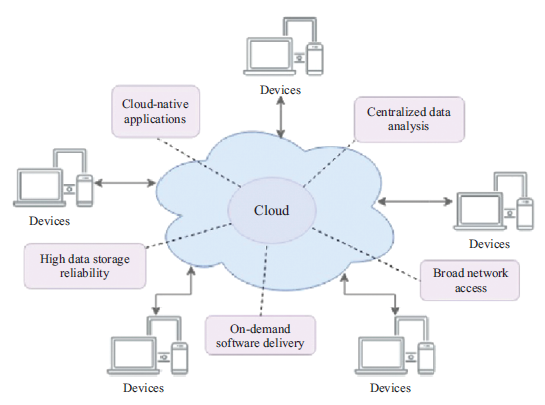

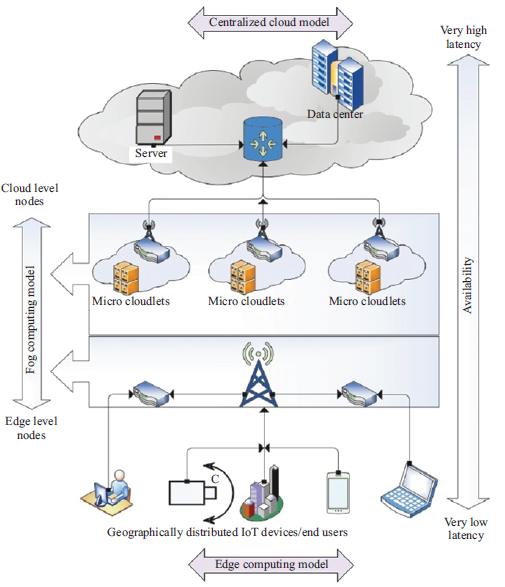

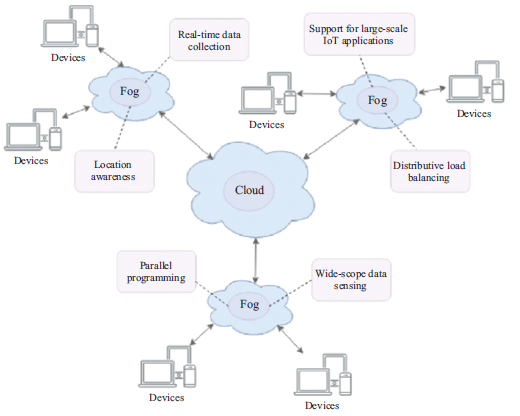

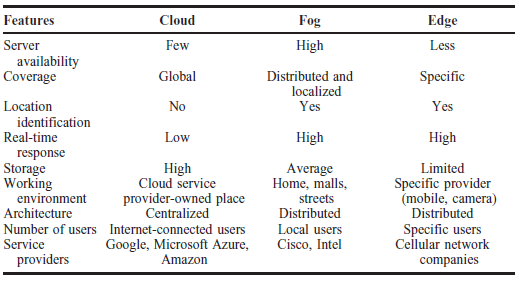

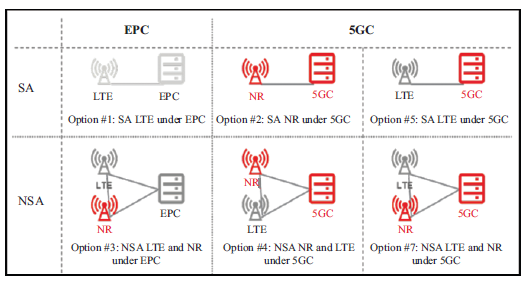

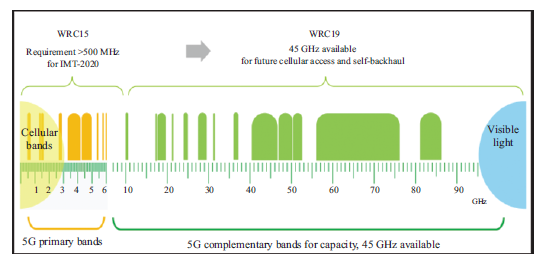

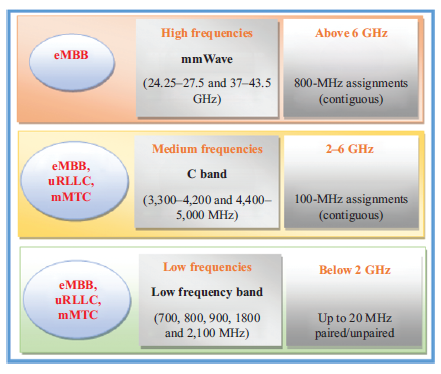

Zbliżające się pojawienie się technologii bezprzewodowej 5G lub piątej generacji oferuje błyskawiczną prędkość, wyjątkowo niezawodne połączenia, niskie opóźnienia i jednocześnie umożliwia ogromną łączność. Oczekuje się, że sieci 5G doładują ekosystem IoT, zapewniając infrastrukturę sieciową niezbędną do przenoszenia ogromnej ilości danych i zaspokajając potrzeby komunikacyjne miliardów urządzeń podłączonych do IoT. Ta bezprzewodowa technologia otwiera szereg nowych możliwości, takich jak robotyka i systemy autonomiczne, technologie chmurowe, zdalna chirurgia i zdalne aplikacje medyczne, AR i pojazdy autonomiczne. Komitet techniczny (TC) 106 Międzynarodowej Komisji Elektrotechnicznej (IEC) otrzymał zadanie opracowania standardów testowania bezpieczeństwa dla urządzeń mobilnych, stacji bazowych i systemów komunikacji bezprzewodowej w celu wsparcia wdrażania i rozwoju sieci 5G. IoT to system powiązanych ze sobą urządzeń komputerowych, maszyn mechanicznych i cyfrowych, obiektów osadzonych w czujnikach, oprogramowania i technologii w celu łączenia i wymiany danych z innymi urządzeniami i systemami przez Internet. Te urządzenia połączone z Internetem Rzeczy obejmują zarówno przedmioty gospodarstwa domowego, takie jak urządzenia kuchenne i elektroniczne nianie, jak i zaawansowane narzędzia przemysłowe, takie jak inteligentne sieci energetyczne, inteligentna produkcja, połączona i inteligentna logistyka oraz konserwacja zapobiegawcza i predykcyjna. Firmy będą wdrażać tysiące lub miliony przewodowych i bezprzewodowych czujników, które wytwarzają duże ilości nieprzetworzonych danych, które są przekształcane w przydatne informacje zapewniające wartość dla użytkownika. Według IEC, roli IEC w IoT, szacuje się, że do 2020 r. zostanie połączonych 50 miliardów obiektów. ISO/IEC JTC 1/SC 41 zapewnia standaryzację w obszarze IoT i powiązanych technologii, w tym sieci czujników i technologii ubieralnych aby zapewnić, że połączone systemy są płynne, bezpieczne i odporne. Robotyka i systemy autonomiczne to obszary, które stale rozwijają się w branży rynkowej na całym świecie. Ze względu na nieograniczone możliwości przechowywania informacji, wraz z wdrażaniem sztucznej inteligencji i ulepszonymi interakcjami człowiek-komputer, robotyka i systemy autonomiczne są odczuwalne we wszystkich dziedzinach i mają niezliczone zastosowania. Technologie chmury są częścią czynnika umożliwiającego przełomowe innowacje, które integrują usługi i demokratyzują dostęp do informacji, uczenia się i komunikacji. Big data i analityka zostały uznane na całym świecie za towary cenniejsze niż ropa, ponieważ dane królują w dzisiejszej gospodarce cyfrowej. Dzisiejsze możliwości gromadzenia i przechowywania ogromnej ilości danych, szybsze i inteligentniejsze analizowanie danych, big data i analityka umożliwiają przekształcenie danych historycznych i danych czasu rzeczywistego w cenne informacje umożliwiające zrozumienie, produkcję, sprzedaż, przewidywanie i tak dalej. AR to integracja informacji cyfrowych ze środowiskiem użytkownika w czasie rzeczywistym, zapewniając interaktywne, oparte na rzeczywistości środowisko wyświetlania, które tworzy pomost między wirtualną rzeczywistością a danymi. Zastosowania AR są nieograniczone. Branże przyjmują technologie AR, aby umożliwić wirtualną produkcję, w której inżynierowie mogą projektować i oceniać nowe części do zastosowań przemysłowych w środowisku 3D; specjalistyczne i rozszerzone szkolenia i symulacje; inteligentne funkcje sterowania i konserwacji oraz wiele innych. Blockchain to zdecentralizowana baza danych, która jest zaszyfrowana, niezmienna, obopólna, weryfikowalna, przejrzysta i trwała. Istnieje niezliczona ilość potencjalnych zastosowań technologii blockchain, a jednym z nich jest "Bitcoin". W branży logistycznej blockchain jest używany do ustanawiania zaufanych informacji, takich jak: gdzie produkt został wyprodukowany, kiedy produkt został wyprodukowany, kiedy produkt został wysłany, gdzie produkt się znajduje i kiedy produkt dotrze. Technologia Blockchain została również wdrożona w sektorze energetycznym, takim jak handel energią odnawialną (RE) typu peer-to-peer (P2P) oraz infrastruktura ładowania pojazdów elektrycznych. Grupa robocza ISO/IEC JTC 1/SC 27 (WG) nadzoruje standardy rozwoju technologii blockchain i rozproszonej księgi rachunkowej. Główne filary lub napędy technologiczne Przemysłu 4.0 obejmują autonomię i sztuczną inteligencję, w których procesy produkcyjne lub produkcyjne będą coraz bardziej zdigitalizowane i połączone ze sobą cyberfizycznymi systemami. Uznanie branży i szerokie zastosowanie sztucznej inteligencji i automatyzacji na nowo zdefiniują sposób działania firm i branż. W związku z tym oczekuje się, że sztuczna inteligencja będzie jednym z najważniejszych czynników wspomagających i cyfrowej granicy w ewolucji technologii informacyjnej (IT). AI to nie tylko pojedyncza technologia, ale także różnorodne technologie oprogramowania i sprzętu wykorzystywane w aplikacjach. Sztuczna inteligencja jest ogólnie rozumiana jako odnosząca się do maszyny, która ma zdolność replikowania ludzkich funkcji poznawczych w celu uczenia się i rozwiązywania problemów. Komponenty sztucznej inteligencji, takie jak sieci neuronowe, przetwarzanie języka naturalnego, biometria, rozpoznawanie twarzy, rozpoznawanie gestów, miniboty i analityka wideo umożliwiają cyfrową transformację. Niedawny artykuł Forbesa "Sztuczna inteligencja pokona szum szumu oszałamiającym wzrostem" sugeruje, że inwestycje w sztuczną inteligencję rosną bardzo szybko. Firma ze Stamford w stanie Connecticut stwierdziła, że wdrożenia sztucznej inteligencji wzrosły o 37% w 2018 r. i 270% w ciągu ostatnich 4 lat. IDC Corp., międzynarodowa firma inwestycyjna, prognozuje, że wydatki na systemy kognitywne i sztucznej inteligencji wyniosą 77,6 mld USD do 2022 r. i zauważa, że 60% światowego PKB powinno zostać zdigitalizowane do 2022 r., co przyniesie prawie 7 bilionów USD wydatków na IT. Obecnie wszystkie sektory w dużym stopniu polegają na sztucznej inteligencji, od finansów, produkcji i robotyki po opiekę zdrowotną, transport, sprzęt AGD, a nawet smartfony, które nosimy wszędzie! Sztuczna inteligencja ewoluuje i rozszerza się znacznie szybciej, niż kiedykolwiek sobie wyobrażaliśmy. Dlatego ważne jest, aby standaryzacja technologii sztucznej inteligencji była potrzebna do osiągnięcia i przyspieszenia globalnego przyjęcia i transformacji cyfrowej.

Jakie decyzje moralne powinny być wykonane przez sztuczną inteligencję w autonomicznych samochodach w sytuacjach życia i śmierci? Na przykład, jeśli nagle zawodzą hamulce, czy samochód powinien skręcić w lewo i prawdopodobnie spowodować śmierć jednego człowieka, czy też powinien skręcić w prawo i spowodować obrażenia u 20 osób? Systemy sztucznej inteligencji muszą być przejrzyste, aby umożliwić użytkownikom zrozumienie, w jaki sposób podejmowane są decyzje związane z SI. Kluczowymi barierami we wdrażaniu sztucznej inteligencji są wiarygodność i względy etyczne systemu, ponieważ ludzie ufają maszynom. Ekosystem sztucznej inteligencji można podzielić na trzy kluczowe obszary obejmujące względy techniczne, społeczne i etyczne. Kwestia techniczna obejmuje podstawowe standardy i metody obliczeniowe, techniki, architektury i charakterystyki systemów sztucznej inteligencji. Względy społeczne i etyczne dotyczą tego, w jaki sposób przyjęcie sztucznej inteligencji wpływa i wpływa na życie ludzkie na siłę roboczą, prywatność, podsłuchiwanie, stronniczość algorytmiczną i bezpieczeństwo. IEC rozpoczęła opracowywanie norm inteligentnej produkcji z Międzynarodową Organizacją Normalizacyjną (ISO), takich jak udział wspólnego komitetu technicznego, ISO/IEC JTC 1 - środowisko opracowywania norm dla ICT w celu utworzenia grup roboczych w celu zbadania harmonizacji istniejących odniesień modeli i nadzoruje rozwój podstawowej architektury dla inteligentnej produkcji. Wspólny komitet techniczny IEC i ISO ds. sztucznej inteligencji, ISO/IEC JTC 1/SC 42, został powołany w celu opracowania międzynarodowych standardów obejmujących obszary obejmujące sztuczną inteligencję, duże zbiory danych, przypadki użycia, implikacje zarządzania, podejścia obliczeniowe sztucznej inteligencji oraz kwestie etyczne i społeczne. obawy. Grupy oceny standaryzacji IEC (SEG) są tworzone w celu identyfikacji nowych obszarów technicznych i przewidywania pojawiających się rynków lub technologii, takich jak inteligentna produkcja, technologie komunikacyjne i inteligentne systemy domu/biura. IEC SEG 10 - Etyka w zastosowaniach autonomicznych i sztucznej inteligencji - ma na celu ocenę prac obejmujących szeroki obszar nowych technologii w celu identyfikacji problemów etycznych i problemów społecznych w całej swojej pracy oraz współpracy z szerszymi komisjami technicznymi w ramach IEC opracowanie szeroko stosowanych wytycznych dla komitetów IEC dotyczących aspektów etycznych związanych z zastosowaniami autonomicznymi i sztuczną inteligencją. Stowarzyszenie Normalizacyjne Instytutu Inżynierów Elektryków i Elektroników (IEEE) (SA) pracowało nad projektami, które koncentrują się na dobrostanie człowieka w tworzeniu autonomicznych i inteligentnych technologii. IEEE-SA wydało wytyczne etyczne dla automatyzacji i inteligentnych systemów, zatytułowane "Ethically Aligned Design (EAD)". Niniejsze wytyczne skupiają się na ogólnych zasadach i zaleceniach dotyczących etycznego wdrażania autonomicznych i inteligentnych systemów, które są ujęte w ośmiu ogólnych zasadach: prawa człowieka, dobrostan, agencja danych, skuteczność, przejrzystość, odpowiedzialność, świadomość nadużyć i kompetencje. Sztuczna inteligencja pomaga usprawnić wydajność firm zajmujących się inteligentną produkcją, ponieważ może zapewnić wgląd w to, gdzie można wprowadzić ulepszenia i, co ważniejsze, gdzie firmy mogą pójść dalej w zakresie planowania produkcji. Standaryzacja ma kluczowe znaczenie dla Przemysłu 4.0, który wymaga bezprecedensowego stopnia integracji systemu ponad granicami domen, granicami hierarchicznymi i fazami cyklu życia. Międzynarodowe organizacje zajmujące się opracowywaniem standardów odgrywają kluczową rolę w przejściu na Przemysł 4.0. Centra danych są podstawą Przemysłu 4.0, ponieważ torują drogę aplikacjom Przemysłu 4.0. Ponieważ przetwarzanie w chmurze i ekosystemy wciąż stają się jedną z kluczowych strategii cyfrowej transformacji, hiperskalowe centra danych zwiększają swoją pojemność, aby sprostać wykładniczemu wzrostowi ilości danych. Centra danych są obecnie domem dla silników AI, rozległych ekosystemów chmurowych, technologii blockchain, zaawansowanych architektur łączności, wysokowydajnych platform obliczeniowych i wielu innych. ISO/IEC JTC 1/SC 38 służy jako jednostka skupiająca, proponująca i integrująca systemy w chmurze obliczeniowej i platformach rozproszonych. Aby przygotować się na kolejną granicę transformacji cyfrowej, centra danych muszą wdrożyć zaawansowaną infrastrukturę sieciową, aby ich sieci były szybsze, bardziej elastyczne, solidniejsze i bardziej niezawodne oraz bardziej odporne i bezpieczne. Centra danych o dużej skali są dużymi konsumentami energii elektrycznej. Niezbędne jest uczynienie centrów danych bardziej energooszczędnymi i mniej energochłonnymi, aby walczyć z rosnącą globalną emisją dwutlenku węgla. Norma ISO/IEC JTC 1/SC 39 została ustanowiona w celu opracowania nowej metryki, która mierzy i porównuje wydajność energetyczną i trwałość centrów danych. Aby to uchwycić, globalna standaryzacja wnosi istotny wkład w zapewnienie płynnej ekspansji transformacji cyfrowej i Przemysłu 4.0 oraz umożliwia łączenie i współdziałanie systemów różnych producentów bez potrzeby specjalnych wysiłków integracyjnych, a także łagodzenie zmian klimatycznych i ograniczanie globalnego poziomu emisji dwutlenku węgla. emisji, które są zgodne z celami zrównoważonego rozwoju Organizacji Narodów Zjednoczonych (ONZ)

Przemysł 4.0 i zrównoważony rozwój

Państwa członkowskie ONZ przyjęły agendę 2030 na rzecz zrównoważonego rozwoju, która stanowi wspólny plan dla pokoju i dobrobytu, obejmujący 17 celów zrównoważonego rozwoju, w ramach których wszystkie kraje rozwinięte i rozwijające się będą współpracować ze strategiami na rzecz poprawy zdrowia i edukacji, pobudzenia wzrostu gospodarczego, zmniejszenia nierówności , przeciwdziałanie zmianom klimatu i ochrona naszego środowiska.Badanie przeprowadzone przez Organizację Narodów Zjednoczonych ds. Rozwoju Przemysłowego (UNIDO) i partnerów wykazało, że Przemysł 4.0 może sprostać globalnym wyzwaniom dzięki zwiększonemu wykorzystaniu technologii informacyjnych i komunikacyjnych, ale ostrzega, że jego ograniczenia i zagrożenia dla zrównoważonego rozwoju muszą być lepiej zrozumiane. Zasada przewodnia Przemysłu 4.0 koncentruje się na zwiększeniu wydajności, wzrostu przychodów i konkurencyjności oraz musi przezwyciężyć wyzwania związane ze standaryzacją systemów, platform, protokołów, zmianami w organizacji pracy, cyberbezpieczeństwem, dostępnością i jakością wykwalifikowanych pracowników, badaniami i inwestycjami oraz przyjęciem odpowiednich ram prawnych, aby odnieść sukces. Przemysł 4.0 musi radzić sobie z produkcją w ramach ograniczeń środowiskowych, aby napędzać zrównoważony rozwój. Tempo eksploatacji zasobów naturalnych nie może przekraczać tempa regeneracji; wyczerpywanie się zasobów nieodnawialnych musi wymagać porównywalnych alternatyw i tak dalej. Rosnący trend zapotrzebowania na energię wynikający z postępu transformacji cyfrowej wymaga pilnego przyjęcia niskoemisyjnych systemów energetycznych. SDG 7 promuje niedrogą i czystą energię. Energia odnawialna i efektywność energetyczna to dwa główne elementy systemów zrównoważonej energii. SDG 7 ma na celu zwiększenie udziału odnawialnych źródeł energii w globalnym miksie energetycznym i znaczne podwojenie globalnego tempa poprawy efektywności energetycznej. Połączenie Przemysłu 4.0 i zrównoważonej energii kierowanej przez cele zrównoważonego rozwoju poprzez transformację sektora energetycznego z transformacją cyfrową znacząco zmieni sposób, w jaki ludzie żyją, konsumują, produkują i handlują. Rozwój technologii ICT, sieci 5G i technologii blockchain otwiera nowe możliwości i zapewnia rozwiązania integrujące odnawialne źródła energii, od wiatru po energię słoneczną, do małych i dużych sieci energetycznych. Technologie cyfrowe zapewniają możliwość monitorowania i efektywnego zarządzania wytwarzaniem, dostawą i zużyciem energii w celu zaspokojenia różnych wymagań użytkowników końcowych. Przemysł 4.0 ma również możliwość wspomagania sektora produkcyjnego w oszczędzaniu energii poprzez przekształcanie procesów biznesowych. Niektóre z podejść, takie jak magazynowanie energii, oferują korzyści związane z bezpieczeństwem dostaw, elastycznością sieci i redukcją obciążeń szczytowych oraz optymalizacją określonej technologii, w której zachowanie dużej liczby połączonych ze sobą robotów jest kontrolowane przez algorytm w celu zmniejszenia ich zużycia energii. Cel zrównoważonego rozwoju nr 9 promuje przemysł, innowacje i infrastrukturę poprzez budowanie silnej infrastruktury, promowanie inkluzywnej i zrównoważonej industrializacji oraz wspieranie innowacji. Wdrożenie technologii 5G i rozwój Internetu Rzeczy pobudzą wzrost inwestycji w infrastrukturę ICT i pojawienie się nowych innowacyjnych podejść. Strategiczna polityka przemysłowa zapewnia podstawową infrastrukturę niezbędną do wspierania innowacji. Bezrobocie jest również najczęściej omawianym zagrożeniem, ponieważ coraz powszechniejsze stosowanie robotyki i systemów automatyzacji zastępuje miejsca pracy, które w przeszłości były motorem produkcji. Jednak to samo portfolio technologii oferuje również możliwość tworzenia nowych miejsc pracy dla wykwalifikowanych pracowników, a integracja inteligencji w maszynach produkcyjnych przyczynia się do zrównoważonego uprzemysłowienia. Przyjęcie Przemysłu 4.0 wymaga od nas przezwyciężenia nie tylko barier technologicznych, ale także, co ważniejsze, barier psychologiczno-ludzkich, które określają sposoby, w jakie ludzie wchodzą w interakcje i wykorzystują te technologie cyfrowe. Obecnie technologie cyfrowe są coraz bardziej humanizowane wraz z dojrzewaniem takich elementów, jak rzeczywistość wirtualna i rzeczywistość rozszerzona. W związku z tym firmy muszą zintensyfikować swoje wysiłki związane z transformacją cyfrową poprzez podejście skoncentrowane na człowieku, aby przejść do pomyślnego wdrożenia.

Rewolucja przemysłowa 4.0 - big data i analityka big data dla inteligentnej produkcji

Inteligentna produkcja i system cyber-fizyczny

Producenci na całym świecie konkurują na globalnym i dynamicznym rynku wymagającym produktów o najwyższej jakości i najniższej cenie. Pod dalszym wpływem czasu do wprowadzenia na rynek i innowacyjności, procesy produkcyjne były stopniowo przesuwane w kierunku swoich granic granicznych, a wywołując znaczną niepewność produkcji, jeśli nie jest kontrolowana, może skutkować katastrofalną awarią. Ten scenariusz wskazuje na znaczenie dostosowania inteligentnych rozwiązań w produkcji w celu efektywnego i wydajnego zarządzania zasobami, zmniejszenia niepewności produkcji, aby zachować konkurencyjność i utrzymać rentowne marże zarówno lokalnie, jak i globalnie. Przemysł 4.0 (I4.0) obejmuje różne technologie, ale koncentruje się na wysoce zautomatyzowanych, zdigitalizowanych procesach produkcyjnych i zaawansowanej technologii komunikacji informacyjnej. I4.0 jest zakorzeniony w koncepcji smartmanufacturing (SM), inteligentnej koncepcji produkcji, w której linie produkcyjne mogą samooptymalizować się i dostosowywać w odpowiedzi na zmieniające się procesy i warunki produkcyjne. SM ułatwia wysoką elastyczność produkcji i zdolność do wytwarzania produktów o większej złożoności i dostosowywania na dużą skalę, podniesienia jakości produktu i osiągnięcia lepszego zużycia zasobów. SM można zdefiniować jako nowy poziom modelu produkcyjnego z kombinacją różnych technologii w celu zintegrowania możliwości cyberfizycznych umożliwiających gromadzenie ogromnych danych z wielu źródeł w połączonym sieciowo środowisku współdzielenia zasobów, wykorzystującym zaawansowane techniki analityczne do opracowywania strategicznych informacji dla systemu doskonalenie i podejmowanie decyzji w celu zwiększenia elastyczności produkcji i zdolności adaptacyjnych. Jest to wzmocnione i wszechobecne zastosowanie sieciowych technologii informatycznych w całej domenie produkcyjnej w celu osiągnięcia optymalnych zdolności produkcyjnych. SM wymaga kilku podstawowych technologii do nawiązania komunikacji różnych podmiotów w obszarze produkcyjnym. Komunikacja i wymiana informacji pozwalają na zmianę zachowania każdego obiektu i adaptację do różnych sytuacji w oparciu o sygnały wytworzone przez przeszłe doświadczenia i zdolności uczenia się wzmocnione przez te technologie, które były dla nich sprzężeniem zwrotnym. Wpływ ten prowadzi do ustanowienia systemów komunikacyjnych między człowiekiem a człowiekiem i człowiekiem z maszynami, znanych jako system cyber-fizyczny (CPS). CPS to koncepcja wywodząca się z funkcjonalności systemów, które umożliwiają dostęp i interoperacyjność człowiek-maszyna. Shafiq i inni stwierdzają, że CPS jest ustanowieniem globalnej sieci wszystkich podmiotów produkcyjnych, od maszyn produkcyjnych po procesy i zarządzanie łańcuchem dostaw (SCM) z konwergencją świata fizycznego i cyfrowego. Monostori i inni stwierdzają, że CPS są podmiotami zdolnymi do współpracy obliczeniowej z otaczającym światem fizycznym poprzez rozległe połączenie, w ciągłej formie dostarczania i wykorzystywania, a także jednoczesnego dostępu i przetwarzania danych z usług dostępnych w sieci. Lee i inni przedstawił dokładny opis CPS w architekturze 5C podsumowujący podstawowe poziomy projektowe CPS: (1) Połączenie, (2) Konwersja, (3) Cyber, (4) Poznanie i (5) Konfiguracja. Poziom połączenia służy jako interfejs między środowiskiem fizycznym a obliczeniowym światem cybernetycznym. Do gromadzenia informacji wykorzystano różne media komunikacyjne, takie jak czujniki, siłowniki, terminale systemów wbudowanych i sieć bezprzewodowa do wymiany danych. Aby dostosować się do różnych typów akwizycji danych, potrzebny jest odpowiedni protokół i konstrukcja urządzenia. Poziom konwersji pełni funkcję agenta przetwarzania danych, który przekształca zebrane dane w użyteczne informacje specyficzne dla każdego procesu w celu podjęcia odpowiednich działań w celu poprawy wydajności. Ponieważ dane z każdego z podmiotów reprezentują jego stan, opracowane informacje mogą służyć jako monitor samoświadomości maszyny. Poziom cyber pełni centralną rolę w tej architekturze. Zbiera wszystkie dane ze wszystkich komponentów w systemach i tworzy cybersymbole właściwości fizycznych. Replikacja tych symboli umożliwia budowanie rosnącej bazy wiedzy dla każdej maszyny lub podsystemów. Właściwe wykorzystanie bazy wiedzy stworzonej do działań doskonalących system może dać bardziej wiarygodne i efektywne rezultaty. Poziom poznania działa jak mózg architektury. Symulacja i synteza wszystkich dostępnych informacji zapewnia dogłębną wiedzę o systemach. Uzyskane w ten sposób wnioski i wyniki mogą być następnie wykorzystywane przez ekspertów do wspierania metod podejmowania decyzji i rozumowania. Ostatnim poziomem jest poziom konfiguracji, elastyczny system sterowania łączący polecenia, sugestie lub decyzje opracowane do realizacji w systemach fizycznych. Dynamiczna wymiana informacji w czasie rzeczywistym pomiędzy zintegrowanym systemem CPS umożliwia komunikację pionową i poziomą w celu podejmowania trafnych decyzji biznesowych, współpracy wielostronnej, wydajnego i efektywnego ulepszania i konserwacji systemu w obrębie całej domeny SM. Ogólnie rzecz biorąc, w kontekście SM, CPS ustanowiło innowacyjne podejście do integracji funkcjonalności systemów automatyki przemysłowej wszystkich podmiotów w domenie systemu produkcyjnego poprzez połączenie sieciowe z całą otaczającą rzeczywistością fizyczną, umożliwiając współpracę obliczeniową i infrastrukturę komunikacyjną w celu zapewnienia interoperacyjności. Systemy są połączone w rozproszonej strukturze modułowej, w przeciwieństwie do połączenia jednokierunkowego w konwencjonalnych zakładach produkcyjnych, co pozwala na interakcję danych z wielu źródeł i integrację wiedzy w sieciach. Zapewnia to całkowitą widoczność i kontrolę nad procesami produkcyjnymi, umożliwiając szybkie rozwiązywanie problemów i podejmowanie decyzji. Informacje są dostępne i przepływają w dowolnym miejscu i czasie we wszystkich obszarach procesów produkcyjnych. Chociaż CPS ustanowił model komunikacji między systemem fizycznym a światem cybernetycznym, to połączenie kilku podstawowych technologii ożywia system SM. Na przykład Internet rzeczy (IoT) umożliwia podłączenie wszystkich fizycznych urządzeń lub sprzętu do scentralizowanej platformy w celu gromadzenia i wymiany danych. Big data (BD) produkowane przez każdy z podmiotów zawiera bezcenne informacje o domenie, które następnie są analizowane za pomocą zaawansowanych technik analityki BD (BDA). Jak wyjaśniono wcześniej, wynik analizy tworzy sygnały, które mają być informacją zwrotną dla systemów w celu dostosowania. Przetwarzanie w chmurze (CC) pozwala na dostęp do informacji i sygnału przez każdą ze stron w systemie SM w czasie rzeczywistym, w dowolnej części świata, o ile jest ona podłączona do sieci. Ostatecznie każda z technologii bazowych wspólnie tworzy podstawową architekturę SM. W niniejszym omówieniu skupimy się na wyjaśnieniu BD i BDA, a następnie na studium przypadku dotyczącym propozycji BDA do pomiaru optycznego w produkcji ogniw słonecznych.

Przegląd dużych zbiorów danych

Cyfryzacja procesów produkcyjnych umożliwiła połączenie różnych urządzeń i podprocesów w zakładach produkcyjnych w dużą platformę cyfrową. Powszechna integracja technologii informacyjno-komunikacyjnych generuje ogromną pojemność heterogenicznych danych pochodzących z różnych obiektów w domenie. Ta ogromna ilość ustrukturyzowanych, częściowo ustrukturyzowanych i nieustrukturyzowanych danych jest znana jako BD. Rozważając pozyskanie danych korespondencyjnych, ze względu na ich ogromną pojemność, uzyskanie, przechowywanie i analizowanie tych danych jest dużym wyzwaniem zarówno pod względem czasu, jak i pieniędzy. W związku z tym wykorzystanie nowatorskich technologii z dzisiejszej ery Internetu ma kluczowe znaczenie dla zapewnienia wartości dla przemysłu. Liczne publikacje dotyczące składników i definicji BD oraz opis szybko ewoluowały i do pewnego stopnia wywołały pewne zamieszanie. BD często rozumie przez wielu, w zależności od objętości i rozmiaru danych. Chociaż ilość i rozmiar danych są nieuchronnie niezbędne, nie jest to jednak jedyny kluczowy aspekt. Zarówno Cemernek i inni jak Gandomi i Haider stwierdzili dwie wersje definicji BD, które najdokładniej opisują BD, zebrane najpierw z definicji przez TechAmerica Foundation:

Big data to termin, który opisuje duże ilości złożonych i zmiennych danych o dużej prędkości, które wymagają zaawansowanych technik i technologii umożliwiających przechwytywanie, przechowywanie, dystrybucję, zarządzanie i analizę informacji.

Inna bardziej powszechna definicja, dostosowana do I4.0 przez Gartner IT Group, jest następująca:

Big data to zasoby informacyjne o dużej objętości, dużej szybkości i dużej różnorodności, które wymagają opłacalnych, innowacyjnych form przetwarzania informacji w celu lepszego wglądu i podejmowania decyzji.

Z obu definicji wyraźnie wynika, że BD zawiera kilka cech ze standardowymi wspólnymi cechami Objętości (Volume) , Różnorodności (Variety) i Prędkości (Velocity), znanych jako trzy V. V są opisane poniżej. Objętość odnosi się do rozmiaru i skali danych. Rozmiary dysków BD zwykle mieszczą się w zakresie wielu terabajtów i petabajtów. Nie było określonego progu pojemności dla klasyfikacji objętości BD. Jest względna i zależy od różnych czynników, takich jak typ danych, technologia kompresji danych, zarządzanie danymi i pojemność pamięci. Na przykład zwiększenie pojemności pamięci zwiększy próg charakterystyki objętości BD, umożliwiając przechowywanie większej ilości danych. Oprócz technologii kompresji danych w celu zmniejszenia rozmiaru danych bez utraty informacji, różne typy danych, takie jak dane tekstowe w stosunku do danych wideo, które mają różną gęstość danych, oraz technologia zarządzania danymi do manipulowania danymi, są możliwymi czynnikami zmiany definicji objętości, ponieważ 'duża'. Różnorodność odnosi się do różnorodności struktury danych i wielowymiarowości zawartości danych. Dane BD istnieją w trzech kategoriach: (1) Dane strukturalne - ten typ danych znajduje się w stałych polach w ramach predefiniowanych ram wejściowych lub modelu danych, takich jak rekord w relacyjnej bazie danych i wpis w arkuszach kalkulacyjnych. Nie wymaga stosowania wstępnego przetwarzania lub wstępnego kondycjonowania danych do jednoznacznej interpretacji lub analizy w celu uzyskania znaczących informacji. (2) Dane nieustrukturyzowane - rodzaj niezorganizowanego, niespójnego formatu, który nie jest zgodny z żadnym wstępnie zdefiniowanym modelem danych ani sposobem. Dane mają zazwyczaj dużą zawartość tekstową i graficzną, często nie nadają się do analizy bez wstępnego przetworzenia lub wstępnego kondycjonowania w celu spełnienia wymagań organizacji strukturalnych technik analitycznych. Dane obrazu, dźwięku i obrazu to przykład danych nieustrukturyzowanych. (3) Dane częściowo ustrukturyzowane - typ danych, który nie jest ściśle zgodny z żadnym formalnym standardem danych, ale zawiera określone identyfikatory umożliwiające rozróżnienie między elementami semantycznymi a elementem instruktażowym w danych. Przykładem danych częściowo ustrukturyzowanych jest język Hypertext Markup Language, w którym informacje o przetwarzaniu zostały zawarte w znacznikach zdefiniowanych przez użytkownika, co umożliwia ich interpretację przez przeglądarkę w celu uzyskania informacji wyjściowych. Prędkość to szybkość generowania danych i szybkość przetwarzania danych w celu uzyskania praktycznych wyników mierzonych częstotliwością. Szybkość generowania danych jest ściśle powiązana z konstrukcją i rozmieszczeniem systemów produkcyjnych. Kiedy cykl produkcyjny czas jest krótki, generowanie danych będzie szybsze i na odwrót. W obu przypadkach CPS kontroluje generowanie danych i ruch. Dlatego projekt CPS powinien mieć odpowiednią zdolność do obsługi scenariusza. Rozprzestrzenianie się urządzeń cyfrowych przyczyniło się do szybkości danych zarówno podczas generowania, jak i przetwarzania. Urządzenia połączone pojedynczo lub grupowo przetwarzały dalej informacje produkcyjne udostępniane na maszynach; pozwala to na uzyskanie bardziej odpowiednich i dogłębnych informacji o konkretnym zadaniu lub scenariuszu, umożliwienie kolejnych działań w zakresie analizy w czasie rzeczywistym i planowania opartego na dowodach. Wielopoziomowe generowanie i przesyłanie nowych danych między urządzeniami przyspiesza bezprecedensową szybkość tworzenia danych. Tradycyjny system zarządzania danymi nie był w stanie obsłużyć ogromnego strumienia danych natychmiast dzięki tej nowej formie szybkości przesyłania danych. To wprowadza nowe technologie BD na scenę, aby manipulować tymi dużymi ilościami danych w "nietrwały" sposób, aby tworzyć inteligencję w czasie rzeczywistym. Oprócz trzech ogólnych wymiarów BD, kilka kluczowych korporacji rozszerzyło wymiar BD na Wiarygodność (Veracity), zmienność(Variability) i wartość(Value). Każdy z rozszerzonych Vs jest opisany poniżej: Wiarygodność reprezentuje zawodność zawartą w niektórych źródłach danych, znaną również jako jakość danych. IBM to wymyślił. Wiarygodność uznano za najważniejszy czynnik utrudniający szerokie przyjęcie BDA w branży. Niektóre zidentyfikowane obszary wpływające na wiarygodność danych, takie jak dokładność, integralność i niepewność danych, wymagają poprawy, zanim możliwe będzie niezawodne wdrożenie . Na przykład popyt rynkowy na takie produkty, jak luksusowe samochody, w dużej mierze zależy od nastrojów klientów, np. preferencji określonych marek, wcześniejszych doświadczeń i statusu społecznego. Wszystko to wiąże się z osądem człowieka, co powoduje znaczną niepewność. Dane te zawierają jednak cenne informacje o rynku. Ten inny aspekt BD należy rozwiązać za pomocą zaawansowanych technik analitycznych, aby uzyskać konkretne i istotne informacje. Zmienność i złożoność to dwa aspekty BD wprowadzone po raz pierwszy przez SAS. W transmisji danych o dużej objętości i prędkości, przepływ danych często wykazuje charakterystykę okresowych szczytów i rowów. Ta niespójność i zmienność nazywana jest zmiennością. Dostępność danych w dzisiejszej erze cyfryzacji pochodzi z niezliczonych źródeł, wytwarzających dane różnych typów i formatów. To wieloźródłowe generowanie danych jest określane jako złożoność i stanowi krytyczne wyzwanie w aplikacji BDA. Dane muszą być wstępnie przetworzone w celu dopasowania i połączenia w celu przekształcenia w znaczące informacje. Wartość została wprowadzona przez Oracle, definiując wartości w BD zebrane na początku wykazują stosunkowo niski koszt w stosunku do pozyskanego wolumenu, określanego jako "gęstość niskowartościowa". Jednak wartość danych wzrasta, gdy są analizowane w dużej ilości w dalszej części rurociągu, ujawniając początkowo ukryte, ekonomicznie uzasadnione spostrzeżenia i informacje o wysokiej wartości. Innymi słowy, wartość reprezentuje szczegółowe informacje uzyskane dzięki zastosowaniu BDA w oparciu o stale dużą ilość analizowanych danych, gdzie informacje te były niewidoczne na początkowym etapie ze względu na stosunkowo małą ilość danych. Wartość danych to najbardziej krytyczny wymiar BD. Nie było uniwersalnego wzorca 3 V, który charakteryzowałby BD. Objętość jako podstawa BD odnosi się do wszystkich innych wymiarów; różnorodność jest związana z jej wartością i tak dalej. Każdy z wymiarów BD był w taki czy inny sposób zależny od siebie. Próg charakterystyki BD zależy od wielkości, obszaru i lokalizacji wdrożenia, a te ograniczenia ewoluują w czasie. Istnieje podstawa do radzenia sobie z BD, w zależności od charakteru i zdolności każdej domeny produkcyjnej. To właśnie tam tradycyjne systemy i technologie zarządzania danymi nie mogą już generować zadowalającej inteligencji w celu utrzymania wydajności produkcji, kontroli kosztów i konkurencyjności. W takiej sytuacji należy dokonać kompromisu między przyszłymi wartościami oczekiwanymi przez wdrożenie technologii BD a kosztami jej wdrożenia. Potencjalne korzyści, jakie można osiągnąć dzięki wdrożeniu BD, będą w dłuższej perspektywie bardziej korzystne w porównaniu z tradycyjnymi systemami i technologiami. Korzystanie z usług BD zapewni przewagę biznesową dzięki zidentyfikowanym możliwościom o wartości dodanej. Dzięki dokładnym analizom może dać systematyczne wskazówki dotyczące odpowiednich działań produkcyjnych, które należy podjąć zgodnie z zachowaniem systemu. Spośród działań podejmowanych w całym cyklu życia produktu pozwala to na uzyskanie efektywnych kosztowo i bezawaryjnych procesów operacyjnych. Pomaga również powiązanemu personelowi w podejmowaniu właściwych decyzji i rozwiązywaniu problemów związanych z operacjami. Jednym z głównych celów SM jest stworzenie inteligentnego systemu produkcyjnego z dokładnym i terminowym podejmowaniem decyzji dzięki wsparciu danych uzyskanych w czasie rzeczywistym. Niewykluczone, że firma BD będzie kolejnym ważnym wkładem w przyszłą transformację i udoskonalenie SM.

Inteligentna produkcja oparta na danych

SM to nowy paradygmat produkcji, w którym wszystkie podmioty w domenie produkcyjnej są w pełni połączone w takiej czy innej formie z siecią. Połączenia sieciowe obejmują czujniki, siłowniki i systemy wbudowane. Wykorzystując podstawowe technologie, takie jak CPS, IoT i CC, można zbierać dane na wszystkich różnych etapach produkcji. Dzięki zaawansowanym algorytmom obliczeniowym dane te można przekształcić w znaczące informacje i spostrzeżenia dotyczące procesów produkcyjnych, tworząc produkcję opartą na danych, zapewniając inteligencję w kontroli jakości, zwiększanie elastyczności i zdolności adaptacyjnych, obniżanie kosztów i nie tylko. Podejście oparte na danych umożliwia wyprowadzenie złożonego, wielowymiarowego nieliniowego modelu charakterystyki danych dla różnych jednostek w domenie bez konieczności dokładnego zrozumienia zachowania systemu. Modelowanie bezpośrednie zapobiega czasochłonnemu i podatnemu na błędy podejściu ręcznemu. Postęp w technologiach sztucznej inteligencji (AI) dodatkowo uzupełnia przyjęcie BD dla SM opartego na danych. Istotnym czynnikiem umożliwiającym ustalenie produkcji inteligencji są dane. Obecne zaawansowane systemy produkcyjne w erze cyfrowej generują wiele rodzajów danych z ogromną pojemnością. W epoce BD dostępność i możliwość gromadzenia dużej puli danych stały się oczywiste i prostsze. Wraz z nowymi technologiami ICT znacznie poprawiło się również gromadzenie, przetwarzanie i przechowywanie danych. Zakłady produkcyjne mogą teraz skorzystać z tych ulepszeń, aby uzyskać korzyści z wartości danych. Następujące kategorie klasyfikują niejednorodne dane przestrzenne z procesów produkcyjnych i urządzeń:

1. Dane zarządcze z podstawową funkcją związaną z podejmowaniem decyzji zarządczych dotyczących kontroli przedprodukcyjnej, takich jak planowanie finansowe, gospodarka materiałowa, logistyka, planowanie produkcji; w kontroli produkcji, takiej jak przepływ materiałów, przepływ produktów, konserwacja; oraz kontrola poprodukcyjna, taka jak sprzedaż i marketing, logistyka i dystrybucja, wysyłka zamówień i obsługa klienta. Dane są zbierane z informacji produkcyjnych, które zawierają różnorodne dane, takie jak system realizacji produkcji (MES), planowanie zasobów przedsiębiorstwa (ERP), zarządzanie relacjami z klientami, SCM i zarządzanie danymi produktu.

2. Dane dotyczące sprzętu są gromadzone za pośrednictwem CPS, który obejmuje dane dotyczące wydajności w czasie rzeczywistym, warunków pracy i historii konserwacji sprzętu produkcyjnego. Dane pochodzące z maszyny zostały zestawione w scentralizowany system informacyjny, który został zaprojektowany i opracowany zgodnie z zakładem produkcyjnym utworzonym za pośrednictwem szkieletowego kanału komunikacyjnego, takiego jak MES. Te zebrane dane można następnie wykorzystać do przekształcenia w systemy podinformacyjne w celu wyświetlania informacji specyficznych dla zadania lub stanu.

3. Dane użytkownika są zbierane ze źródeł internetowych i służą jako dane wejściowe do specjalnych wymagań produkcyjnych, takich jak lokalizacja klientów, dane demograficzne, profile, historia zamówień, preferencje produktowe i inne. Dane te są generowane głównie z głównych zakładów produkcyjnych na zewnętrznych serwerach, które zawierają informacje o klientach, wykorzystywane głównie do celów marketingowych i informacji zwrotnych. Wraz z rozwojem CPS dane te mogą być dalej wykorzystywane po wstępnym przetworzeniu i filtrowaniu w celu integracji z centralnym systemem planowania produkcji. Planowanie produkcji może następnie dostosować się do najnowszych wymagań rynku i przekazać informacje zwrotne na temat najnowszych wymagań produkcyjnych w procesach produkcyjnych. Ta aplikacja zapewnia wysoką elastyczność produkcji i adaptacyjność.

4. Dane produktowe są zbierane z systemów produktowych i produktowo-usługowych za pośrednictwem internetowej bazy danych klientów, technologii IoT, które wytwarzają i informują w czasie rzeczywistym. Dane odzwierciedlają wydajność produktu, kontekst użytkowania, taki jak obszar i czas, oraz wszelkie inne wskaźniki związane z produktem/usługą, takie jak wilgotność, temperatura i wydajność. Dane te służą jako źródło informacji do uzyskania informacji o produkcie w aktualnym obszarze zastosowania. Dane te dostarczają bezcennych informacji na temat faktycznego wykorzystania produktu do przyszłych udoskonaleń.

5. Dane publiczne są zbierane z systemów rządowych lub otwartych baz danych. Przykładami źródeł informacji są protokoły rządowe, zasady i przepisy, własność intelektualna, rozwój naukowy, demografia, ochrona środowiska, opieka zdrowotna, standardy branżowe i inne. Te powiązane dane rządowe są niezbędne do zagwarantowania ścisłej zgodności procesów produkcyjnych i wytwarzanych produktów ze wszystkimi przepisami.

Cykl życia danych

W środowisku produkcyjnym na pełną skalę różne źródła będą generować różne dane. Surowe dane wyodrębnione w oryginalnym stanie nie są w stanie dostarczyć użytkownikom żadnych przydatnych informacji. Klasyfikacja tych danych musi być przeprowadzona w celu odkrycia wiedzy w celu przekształcenia w treść interpretowaną przez użytkownika w celu wyodrębnienia znaczących informacji (IE). Rozważając BD z perspektywy całego cyklu życia produktu produkcyjnego, przekształcenie surowych danych w użyteczne informacje obejmuje wiele etapów. Cała podróż rozciąga się od generowania danych, gromadzenia, przechowywania, przetwarzania, wizualizacji do ostatecznej aplikacji, znanej jako cykl życia danych. Dane produkcyjne wytworzone w całym cyklu życia danych były wykorzystywane w różnych punktach do sortowania według kryteriów danych. Takie sortowanie może podkreślić jego wartość dla zainteresowania użytkowników, np. jakie dane są potrzebne i gdzie jest to istotne w różnych fazach cyklu życia.

1. Źródła danych: Wcześniej wyjaśniono typowy typ danych produkcyjnych i ich pochodzenie. Zarządzanie i wyposażenie to dwa podstawowe typy danych związanych z produkcją. Podstawowe ramy systemu informacyjnego, takie jak MES, łączą wszystkie wytworzone dane dotyczące zarządzania. Systemy te zostały dostosowane i opracowane zgodnie z wymaganiami zakładu produkcyjnego. Dodatkowe podsystemy zapewniające informacje niższego poziomu ukierunkowane na każdą określoną grupę procesów można również wygenerować poprzez integrację z podstawową strukturą. Dane dotyczące zarządzania są zazwyczaj danymi ustrukturyzowanymi, chociaż forma danych podczas transmisji między systemami do schematu była częściowo ustrukturyzowana. Czujniki sprzętu, siłowniki i systemy wbudowane generują dane o sprzęcie. Typ danych różni się w zależności od projektu systemu i zastosowania i jest nieustrukturyzowany. Większość nowoczesnych urządzeń zgodnych z I4.0 zawiera wewnętrzny interfejs systemowy do wstępnego przetwarzania większości danych sprzętowych do postaci częściowo ustrukturyzowanej przed wysłaniem do szkieletu podstawowego.

2. Zbieranie danych: Do zbierania danych produkcyjnych wykorzystano kilka sposobów ze względu na ich powszechną dostępność w różnych jednostkach danych. CPS pozwala na wprowadzenie użytecznych danych fizycznych do świata cybernetycznego. Gromadzenie danych produkcyjnych lub zarządczych odbywa się za pośrednictwem podstawowych systemów komunikacji i zarządzania informacjami, takich jak MES. Generowanie danych dla poszczególnych podmiotów odbywa się za pośrednictwem standardowego interfejsu protokołu przemysłowego, takiego jak SECS/GEM i jest przesyłane do scentralizowanego serwera MES. Dane te mogą być następnie wykorzystane do dalszych zastosowań w czasie pół rzeczywistym lub w czasie rzeczywistym za pośrednictwem technologii bazodanowych. Dane są głównie częściowo ustrukturyzowanymi i nieustrukturyzowanymi danymi maszynowymi. Okres przechowywania danych zależy od pojemności pamięci serwera. IoT to kolejna forma standardowej technologii gromadzenia danych w SM. Dane dotyczące sprzętu i produktów były zbierane natychmiast w celu monitorowania stanu w czasie rzeczywistym za pomocą czujników, inteligentnych czujników i innych systemów wbudowanych podłączonych do sieci. Od powstającej technologii mobilnej gromadzenie danych było możliwe za pośrednictwem terminali, takich jak komputery PC, telefony komórkowe, tablety i laptopy. Gromadzenie danych w oparciu o IoT to na ogół bezpośrednie zastosowanie danych w skali indywidualnej jednostki. Dane te można następnie wykorzystać do tworzenia konkretnych aplikacji, głównie do monitorowania wydajności systemu za pomocą zestawów programistycznych lub interfejsów programowania aplikacji. Dane użytkowników i publiczne wykorzystywały metodę web scrapingu do gromadzenia danych. Web scraping odnosi się do ekstrakcji danych ze stron internetowych w celu uzyskania pożądanych informacji za pomocą bota lub robotów indeksujących. Jest to zazwyczaj zautomatyzowany proces polegający na przeszukiwaniu i kopiowaniu przeszukiwanych witryn internetowych i gromadzonych w bazie danych w celu późniejszego zastosowania. Web scraping jest zwykle stosowany razem ze sztuczną inteligencją, umożliwiając wydajne zbieranie danych.

3. Przechowywanie danych: Cyfryzacja systemów produkcyjnych generuje ogromne ilości danych. Te dane, od surowego sprzętu we/wy po dane systemu zarządzania, muszą być bezpiecznie przechowywane i integrowane, aby umożliwić dostęp i wykorzystanie do kolejnych działań. Pojemność i szybkość przechowywania to dwa krytyczne czynniki określające żywotność danych, okres przechowywania i funkcjonalność danych. Wydajne i bezpieczne przechowywanie danych ułatwi szybkość i dostępność do wykorzystania. Istnieją trzy standardowe klasyfikacje typów danych: (1) Strukturalne, takie jak liczby, zarządzane ciągi, tabele, którymi można zarządzać bezpośrednio w oparciu o bazę danych. (2) Częściowo ustrukturyzowane, takie jak wykresy i XML. Te typy danych nie są bezpośrednio wyodrębniane w celu uzyskania informacji dla użytkownika końcowego. Funkcjonuje głównie jako pośrednie medium pośredniczące w systemach i oprogramowaniu. (3) Niestrukturalne, takie jak pliki dziennika, audio i obrazy. Dane te wymagają specjalistycznego i zaawansowanego podejścia do przetwarzania i pozyskiwania wymaganych informacji specyficznych dla zadania. Ze względu na charakter bezpośredniego IE dla ustrukturyzowanego typu danych, większość firm skupiła się i zainwestowała w nośnik pamięci i dostępność dla tego typu danych. Nowa technologia pamięci masowej opartej na obiektach otwiera okno na wydajne przechowywanie danych częściowo ustrukturyzowanych i nieustrukturyzowanych. Dane są przechowywane i zarządzane jako obiekt, co zapewnia elastyczność w integracji pamięci masowej i ściąganiu do użytku. Kolejną istotną technologią pamięci masowej jest przechowywanie w chmurze. Ma zastosowanie do wszystkich form struktury danych, przechowywanie w chmurze umożliwia energooszczędne, opłacalne, bezpieczne i elastyczne rozwiązanie pamięci masowej. Dane są przechowywane w wirtualnym miejscu przechowywania i z wieloma możliwościami dostępu w dowolnym miejscu i czasie z połączeniem internetowym przez różne podmioty. Dostawca usług przechowywania w chmurze często oferuje funkcje o wartości dodanej, takie jak automatyczne tworzenie kopii zapasowych, gwarantowany czas pracy i funkcje dostępu do wielu urządzeń. Może też współpracować z systemem dostawcy usług w zakresie funkcji analitycznych danych, takich jak głębokie uczenie się, przetwarzanie danych i inne. Wszystkie te funkcje sprawiły, że przechowywanie w chmurze jest wysoce skalowalnym i udostępnianym trybem przechowywania danych.

4. Przetwarzanie danych: można je nazwać serią działań lub operacji mających na celu ujawnienie przydatnych i ukrytych informacji w dużych ilościach danych do odkrywania wiedzy. Surowe dane w ich naturalnej postaci są zazwyczaj rozproszone, nieczytelne i pozbawione znaczenia. Różne procedury przetwarzania danych są zaangażowane w przekształcanie nieprzetworzonych danych w znaczące informacje. Wyodrębnione informacje są przydatne do prowadzenia działań doskonalących, takich jak kontrola jakości, konserwacja predykcyjna i poprawa wydajności w dziedzinie produkcji. Po pierwsze, czyszczenie danych usuwa zbędne, zduplikowane brakujące wartości i niespójne informacje. Następnie procedura redukcji danych służy do przekształcenia dużych zbiorów danych do uproszczonego, uporządkowanego i kompatybilnego formatu zgodnie z wymaganiami zadania dotyczącymi przetwarzania. Wstępnie przetworzone dane są następnie gotowe do wykorzystania poprzez analizę i eksplorację danych w celu opracowania nowych informacji. Wydajność nowej generacji informacji zależy od analizy i szerokiego zakresu dostępnych technik wydobywczych. Ze względu na dużą ilość danych konwencjonalne techniki statystyczne nie są już najlepszą opcją. Zastępuje je nowoczesne uczenie maszynowe (ML), modele prognozowania obliczeń na dużą skalę i zaawansowane techniki eksploracji danych, takie jak klastrowanie, regresja i wiele innych. Optymalne wykorzystanie BD z atrakcyjnymi analizami danych, dogłębną wiedzą i spostrzeżeniami na temat jednostek produkcyjnych. To napędza osiągnięcie wysokich kompetencji i inteligentnej produkcji.

5. Wizualizacja danych: Prezentacja wyniku przetwarzania danych w bardziej wyraźnej formie, aby ułatwić użytkownikom zrozumienie i interpretację. Dostarczanie informacji jest bardziej efektywne w formie wizualizowanej, takiej jak wykresy, diagramy, figury i wirtualna rzeczywistość. Dane w czasie rzeczywistym można wyobrazić sobie online za pośrednictwem dedykowanych kanałów lub platform użytkowników, umożliwiając natychmiastowe udostępnianie informacji. Ponadto dane statyczne przetworzone na formę wizualną i udostępniane przez każdy podmiot promują bardziej bezpośrednią percepcję, dostępność i przyjazność dla użytkownika. Zaawansowane oprogramowanie analityczne zawiera funkcję tworzenia wizualizacji danych, ułatwiającą zadania użytkownikom.

6. Transmisja danych: Nowoczesna zdigitalizowana SM generuje duże ilości danych, a wygenerowane dane przepływają w sposób ciągły przez różne platformy, takie jak sprzęt, CPS i ludzie, przez różne media w trybie rozproszonym. Transmisja tych danych ma kluczowe znaczenie dla zapewnienia skutecznej komunikacji, udostępniania informacji i interakcji między wszystkimi podmiotami w domenie. Obecne postępy w technologiach komunikacyjnych w znacznym stopniu scentralizowały infrastrukturę bezpiecznej i niezawodnej transmisji w czasie rzeczywistym wszelkiego rodzaju danych. W związku z tym rozproszone zasoby produkcyjne w SM można zunifikować praktycznie w dowolnym miejscu i czasie, aby osiągnąć wysoką elastyczność i kompetencje produkcyjne, zachowując konkurencyjność na rynku globalnym.

7. Aplikacja danych: Dane generowane i istniejące w prawie każdym aspekcie nowoczesnej produkcji. Stał się głównym katalizatorem kontroli trzech najważniejszych kryteriów produkcji, a mianowicie wydajności, jakości i kosztów. W utrzymaniu kompetencji dane mają zastosowanie od początku etapu projektowania produktu do końcowego etapu dostawy. Na etapie projektowania można wykorzystać analitykę danych do uzyskania informacji i zrozumienia produktu, który ma być wytwarzany, takich jak popyt rynkowy, konkurencja oferta i ograniczenia technologiczne. Te spostrzeżenia pozwalają na opracowanie unikalnego i zorientowanego na klienta produktu. Następnie, na etapie produkcji, do optymalizacji produkcji można wykorzystać inną formę danych podmiotów produkcyjnych. Dane o sprzęcie w czasie rzeczywistym są śledzone w celu monitorowania ogólnej efektywności sprzętu. Można je dalej analizować na podstawie danych długoterminowych pod kątem konserwacji predykcyjnej, aby wyeliminować nieplanowane przestoje maszyny, które wpłyną na wydajność i koszty. Dane procesowe są wykorzystywane do kontrolowania każdego etapu produkcji, zapewniając zoptymalizowany proces pod kątem jakości produktu i kontroli kosztów produkcji. Analiza danych procesowych może dostarczyć wczesnych ostrzeżeń o tendencji zmian procesu wpływających na jakość produktu, nienormalnie wysokie wykorzystanie surowców i niską wydajność produktu. Pozwala również na diagnozę pierwotnych przyczyn problemów do usunięcia oraz ograniczenie bieżących procesów do dalszego doskonalenia. Dane operacyjne mogą być wykorzystywane do monitorowania wydajności online, aby natychmiast zwrócić uwagę odpowiedniego sprzętu i personelu procesowego. Dane wyjściowe produkcji można analizować, aby sprostać zapotrzebowaniu rynku i planowaniu produkcji. Na końcowym etapie dostawy przeanalizowano dane produkcyjne, zarządcze i rynkowe w celu określenia optymalnego planowania logistycznego, czasu marketingu, wydajności produkcji i innych elementów SCM. Łącznie, dogłębna analiza danych umożliwia wykonanie działań na wczesnym etapie i działań zapobiegawczych, konserwacji zapobiegawczej i predykcyjnej, przewidywania usterek i usprawnień operacyjnych. Krótko mówiąc, dane napędzają nową, nowoczesną produkcję.

Wartość BD for SM nie zależy wyłącznie od dużej ilości danych. Zdolność do efektywnego wykorzystania danych w celu opracowania znaczących informacji jest kluczem do osiągnięcia optymalnych wyników w SM. Standardowe konwencjonalne technologie dostarczane przez twórców oprogramowania i sprzętu skupiały się głównie na ustrukturyzowanych danych do analizy predykcyjnej, które stanowią jedynie niewielki składnik BD. Przedsięwzięcie w nieustrukturyzowane obszary danych, takie jak audio, wideo i nieustrukturyzowane teksty, było ogólnie ignorowane. Jednak trend ulega zmianie wraz z niedawnym wzrostem sztucznej inteligencji. Ten rosnący trend obserwuje więcej wysiłków badawczych i praktycznych podejść przemysłowych wykorzystujących zaawansowane techniki sztucznej inteligencji, takie jak ML, w celu zebrania nowej wymiarowości i przenikliwości nieustrukturyzowanych danych. W ten sposób jest krytyczne podejście do wykorzystania prawdziwego potencjału BD. Istotne dowody wykazały moc i ulepszenia osiągnięte dzięki podejściom AI do danych nieustrukturyzowanych. W następnej sekcji omówiono dokładniej koncepcje analityczne BD, implementację, techniki eksploracji danych i kilka innych aspektów.

Analiza dużych zbiorów danych

Analityka danych jest uważana za gałąź naukowego i inżynieryjnego podejścia do odkrywania ukrytych wzorców, anonimowych informacji i korelacji w systemach. BDfurther pogłębia zapotrzebowanie na możliwości analityczne dzięki swoim cechom definiującym, które powodują niewystarczalność konwencjonalnego zarządzania danymi i analizami w celu zebrania pełnego potencjału BD dla SMapplications. Ograniczenia w podejściu konwencjonalnym, wraz z postępem w zakresie technologii obliczeniowych, doprowadziły do powstania nowej gałęzi technik analitycznych, znanej jako BDA. BDA zyskało ostatnio dużą popularność i trakcję dzięki postępowi i uogólnieniu sztucznej inteligencji. Możliwość analizowania dużych zbiorów danych będzie jednym z głównych czynników utrzymania konkurencyjności biznesu, wzrostu i innowacyjności . BD w swoim surowym formacie nie ma dużej wartości; bez odpowiedniej analizy gromadzenie wartości w celu przekształcenia informacji w użyteczną wiedzę nie ma sensu. Dobra umiejętność analizy danych może zapewnić znaczący wgląd w procesy, zapewnić kilka istotnych korzyści, takich jak śledzenie w czasie rzeczywistym, konserwacja predykcyjna i wiele innych działań mających na celu poprawę systemów i podejmowanie decyzji przez kierownictwo. Promuje autonomiczną interoperacyjność, elastyczność, poprawę systemu i redukcję kosztów. Zjawisko to powoduje przejście w konwencjonalnym paradygmacie produkcji scentralizowanych aplikacji produkcyjnych na koncepcję rozproszonego klastra SM, kluczową w SM. Przewiduje się, że BDA, które dostarcza inteligencję do procesów produkcyjnych, przyczyni się do znacznej poprawy SM. Proces analityczny służący do wydobywania informacji z różnych źródeł i typów danych w ramach BD można podzielić na pięć klas, a mianowicie analizę tekstu, analizę dźwięku, analizę wideo, analizę społecznościową i analizę predykcyjną. Dwa główne podprocesy zaangażowane w proces analityczny, którymi są zarządzanie danymi i analityka danych

Analiza tekstu

Analiza tekstu jest również znana jako eksploracja tekstu. Odnosi się do technik uzyskiwania informacji z danych opartych na teksturach znakowych i liczbowych. Przykładami danych tekstowych są e-maile, gazety, dokumenty, książki i inne. Dane tekstowe dostępne na każdym poziomie każdej organizacji, a także ludzkiego życia są podstawowym źródłem tworzenia nowej wiedzy. Wydajna i efektywna analiza i interpretacja tych danych ujawni wiele ukrytych informacji, dając ogromne możliwości ulepszeń. Analiza statystyczna, lingwistyka komputerowa i ML to trzy główne dziedziny zaangażowane w analizy danych tekstowych. Wynik tych analiz dostarczy wskazówek, wskazówek i potwierdzeń wspierających podejmowanie decyzji dowodami. Przykładem użytecznej aplikacji do analizy tekstu jest obszar Business Intelligence (BI), wydobywający informacje z wiadomości finansowych w celu przewidywania wyników giełdowych. Analiza tekstu składa się z czterech głównych technik opisanych pokrótce poniżej. IE to technika używana do uzyskiwania uporządkowanych danych z nieustrukturyzowanego tekstu. Algorytm IE został zaprojektowany do rozpoznawania jednostki tekstowej i relacji ze źródła tekstowego, tworząc uporządkowane informacje. Najbardziej typowym przykładem IE jest algorytm aplikacji kalendarza do tworzenia nowego wpisu, w tym istotne informacje, takie jak data i miejsce, automatycznie wyodrębniane z wiadomości e-mail. Dwa podzadania wykonywane w IE to rozpoznawanie jednostek (ER) i wyodrębnianie relacji (RE). ER lokuje i organizuje określoną i wstępnie określoną nazwaną jednostkę, która istnieje w nieustrukturyzowanym tekście, w wyznaczonych kategoriach, takich jak lokalizacja, wartości, nazwy i inne. RE bada i wyodrębnia relacje semantyczne między bytami w tekście. Wyodrębniona relacja występowała zwykle między bytami określonych typów i pogrupowana w określone kategorie semantyczne. Na przykład w "Steven mieszka w Malezji" wyodrębnioną relacją może być Osoba [Steven], Lokalizacja [Malezja]. Podsumowanie tekstu to technika, która automatycznie skraca długie fragmenty tekstów do czytelnego i zwięzłego podsumowania, określającego tylko główne punkty. Przykładami zastosowania są nagłówki wiadomości, streszczenia książek, protokoły ze spotkań i inne - dwa konwencjonalne podejścia stosowane w tej technice, a mianowicie podejście ekstrakcyjne i podejście abstrakcyjne. Wyodrębnianie podsumowania tworzy podsumowanie z oryginalnych jednostek tekstowych, co daje podzbiór oryginalnego dokumentu w skróconym formacie. Ekstrakcyjna technika podsumowania nie "rozumie" tekstu. Podsumowanie zostało sformułowane poprzez określenie wyróżniających się jednostek tekstowych i połączenie ich ze sobą. Wyeksponowanie jednostek zdaniowych ocenia się na podstawie ich częstotliwości występowania i lokalizacji w tekście. W tej technice często stosuje się wyszkolone modele ML, aby filtrować przydatne informacje w tekstach i przedstawiać je w podsumowaniu, przekazując najważniejsze informacje. W przeciwieństwie do tego, streszczenie abstrakcyjne wyodrębnia informacje językowe z tekstu i generuje podsumowanie za pomocą nowych zdań utworzonych przez nowe jednostki tekstu lub przeformułowanie, zamiast destylować krytyczne zdanie. Do przetwarzania tekstów i generowania streszczenia wykorzystywane są zaawansowane techniki przetwarzania języka naturalnego (NLP). Odpowiednio, można tworzyć bardziej spójne podsumowania. Jednak ze względu na ich złożoność i trudniejsze przyjęcie, podsumowania ekstrakcyjne są częściej stosowane w przypadku BDA. Odpowiedzi na pytania (QA) to technika odpowiadania na pytania zadawane w języku naturalnym w zdigitalizowanym systemie. Siri firmy Apple, Alexa firmy Amazon, asystent Google i Cortana firmy Microsoft to tylko niektóre przykłady wybitnych systemów kontroli jakości. Z systemów zapewniania jakości korzystało wiele dziedzin, takich jak opieka zdrowotna, bankowość i edukacja. Inteligencja tych systemów polega na zastosowaniu wyrafinowanych technik NLP. Metody systemu QA można dalej podzielić na trzy podejścia, a mianowicie oparte na wyszukiwaniu informacji (IR), oparte na wiedzy i hybrydowe. System zapewniania jakości oparty na podczerwieni zazwyczaj składa się z trzech podkomponentów. (1) Komponent przetwarzania pytań do identyfikacji szczegółów użytych do skonstruowania zapytania, takich jak przypadek i cel pytań oraz typ odpowiedzi. (2) Element przetwarzania dokumentów do wyszukiwania odpowiednich tekstów wstępnie napisanych z zestawu o dużej objętości istniejących dokumentów, przy użyciu informacji wyszukiwania opracowanych na podstawie zapytania wykonanego w trakcie przetwarzania zapytania. (3) Komponent przetwarzania odpowiedzi do filtrowania odpowiedzi kandydatów wejściowych z komponentu przetwarzania dokumentów. Odpowiedzi są następnie klasyfikowane zgodnie z ich trafnością, a następnie zwracają najwyżej ocenioną odpowiedź jako wynik. Systemy kontroli jakości oparte na IR są powszechnie stosowane w obszarach o ogromnym zbiorze gotowych tekstów, takich jak prawo i edukacja. Oparte na wiedzy systemy zapewniania jakości sprawdzają informacje zawarte w zorganizowanym źródle za pomocą opisu semantycznego opracowanego na podstawie pytań wejściowych. System ten składa się z dwóch głównych komponentów: (1) Bazy wiedzy, która zawiera obszerny zbiór informacji o zaprojektowanym polu, zwykle generowanych na podstawie ludzkich opinii eksperckich, używanych jako źródło odniesienia podczas procesu wnioskowania. (2) Silnik wnioskowania, który funkcjonował w celu wnioskowania osądu na podstawie informacji w bazie wiedzy na podstawie wprowadzonych pytań w celu uzyskania poprawnych odpowiedzi. Systemy zapewniania jakości oparte na wiedzy są przydatne w kontrolowanej domenie ze względu na brak dużej ilości wstępnie napisanego tekstu wejściowego; jego informacje w bazie wiedzy są specjalnie zaprojektowane zgodnie z daną dziedziną. Hybrydowe systemy zapewniania jakości to połączenie obu połówek systemów zapewniania jakości opartych na podczerwieni i wiedzy. Pytania są oceniane semantycznie jak w systemie opartym na wiedzy, natomiast odpowiedzi generowane są w podejściu IR. Analiza nastrojów (eksploracja opinii) to technika analizy obliczeniowej danych tekstowych, które zawierają subiektywne informacje, takie jak opinie i myśli. Analiza polega na identyfikacji, filtrowaniu, uzyskiwaniu i kwantyfikacji analitycznej, przy użyciu NLP, analizy tekstu i technik lingwistyki obliczeniowej na danych dla głosów klientów. Firmy stopniowo angażują się w pozyskiwanie większej ilości danych, aby zrozumieć zachowanie swoich klientów, w szczególności w odniesieniu do ich produktów lub usług. Tylko dzięki zrozumieniu klientów firma może przynosić zyski poprzez sprzedaż produktów lub świadczenie usług spełniających wymagania klientów. Takie zachowanie biznesowe doprowadziło do rozpowszechnienia analizy sentymentu. Ze względu na analityczny charakter danych subiektywnych, analiza sentymentu ma większe zastosowanie w marketingu, naukach politycznych i społecznych. Ale ma również zastosowanie w środowiskach produkcyjnych do analizy wydajności pracowników i informacji zwrotnych. Technika analizy nastrojów jest dalej podzielona na trzy podgrupy: (1) Analiza na poziomie dokumentu opiera się na całym dokumencie pod kątem ogólnej klasyfikacji nastrojów jako pozytywne, neutralne lub negatywne. Zakłada się, że dokument reprezentuje lub opisuje jeden podmiot. (2) Analiza na poziomie zdania jest bardziej złożona w porównaniu z analizą dokumentów. Musi najpierw zidentyfikować pojedyncze zdanie ich subiektywnego i obiektywnego, a następnie określić schizmę sentymentalną nad elementami opisanymi w zdaniu. (3) Analiza aspektowa rozróżnia wszystkie poglądy w całym dokumencie i klasyfikuje cechy podmiotu zgodnie z poglądami, umożliwia uzyskanie szerszych i całościowych informacji na temat analizowanego tematu, w przeciwieństwie do pojedynczego podmiotu lub polaryzacji. Pozwala to analizatorowi uzyskać szczegółowe informacje na dany temat z wielu perspektyw.

Analiza dźwięku

Analiza dźwięku to rodzaj analizy przeprowadzanej na nieustrukturyzowanych danych dźwiękowych w celu wyodrębnienia istotnych informacji w celu usprawnienia działalności. Tego typu analiza jest szczególnie istotna w sektorze usług biznesowych. Analiza ludzkiego języka mówionego jest uważana za część analizy dźwięku, zwanej analizą mowy. Wraz ze wzrostem orientacji biznesowej na klienta, analizy audio mogą być stosowane w środowisku produkcyjnym w celu uzyskiwania konstruktywnych danych wejściowych z informacji zwrotnych od klientów opartych na dźwięku w celu poprawy. Istnieją dwa ogólne rodzaje technik analizy dźwięku, a mianowicie analiza fonetyczna i ciągłe rozpoznawanie mowy z dużym słownictwem (LVCSR). Analiza oparta na fonetyce wykorzystuje sekwencję dźwięków w dźwięku lub zdaniu, znaną jako fonem, jako podstawową jednostkę analizy. Fonemy są jednostką różnicującą słowa w medium analitycznym według wymowy. Ta technika obejmuje fazę indeksowania i wyszukiwania. W fazie indeksowania medium jest tłumaczone na sekwencję fonemów. Następnie, w fazie wyszukiwania, algorytm wyszukuje fonetyczną reprezentację wejściowych terminów wyszukiwania. Podejście to koduje fonemy w matrycę możliwości, do której następnie odwołuje się dopasowywanie wyszukiwanych terminów w procesie analizy. Zaletą tej techniki jest możliwość wyszukiwania słów, które nie są z góry określone, jeśli fonemy są identyfikowalne. Przetwarzanie jest również szybsze w porównaniu z LVCSR. Wadą tej techniki jest wolniejszy proces wyszukiwania, ponieważ fonemy nie mogą być zindeksowane, tak jak słowo, i zajmują więcej miejsca w pamięci. Technika LVCSR sprawdza prawdopodobieństwo różnych sekwencji słów przy użyciu podejścia statystycznego, umożliwiając wyższą dokładność w porównaniu z podejściem wyszukiwania fonetycznego. Podobnie jak w przypadku podejścia opartego na fonetyce, zaangażowane są dwie fazy indeksowania i wyszukiwania. W pierwszej fazie indeksowania zaimplementowano specjalny algorytm automatycznego rozpoznawania mowy w celu transliteracji dźwięku lub mowy na pasujące słowa. Słowa zostały wstępnie zdefiniowane w liście słowników. Rozpoznawane jest każde słowo, a najbliższe pasujące słowo zostanie użyte, jeśli nie zostanie znalezione rzeczywiste słowo, w celu utworzenia pełnej transkrypcji mowy z przeszukiwalnym plikiem indeksu. Druga faza wyszukiwania, standardowy algorytm wyszukiwania tekstu, została wykorzystana do przetworzenia wyszukiwanego terminu w transkrypcji. Chociaż technika ta wymaga większych zasobów przetwarzania niż techniki oparte na fonetyce, wygenerowany transkrypcja mowy umożliwia bardziej efektywne i wydajne wykorzystanie zebranych informacji.

Analiza wideo

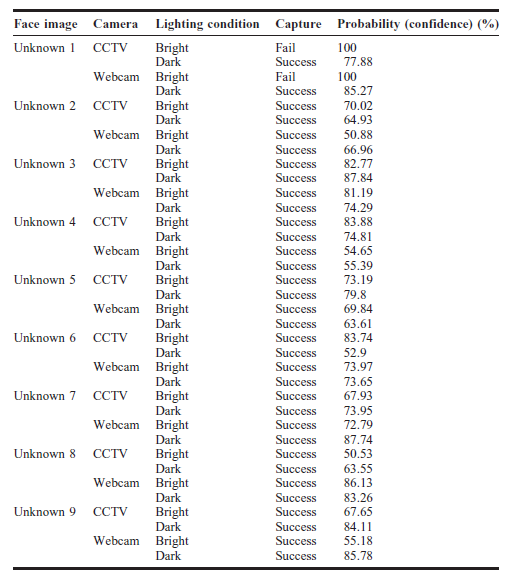

Postęp technologii komputerowych i obrazowania cyfrowego napędza wdrożenie analizy treści wideo (VCA) w celu uzyskania ważnych informacji z treści wideo. Wraz ze zwiększoną mocą obliczeniową można wdrożyć VCA w celu niemal natychmiastowego generowania znaczących informacji i spostrzeżeń. Nowoczesne zakłady produkcyjne wyposażone w dużą liczbę systemów CCTV i kamer do monitorowania procesów produkcyjnych, stanu urządzeń i przepływów materiałów na hali produkcyjnej. Dzięki takim urządzeniom do obrazowania, kontrolerzy produkcji będą mogli monitorować wszystkie ważne procesy w scentralizowanej sterowni. Dysk BD wygenerowany z kanałów wideo może być dalej analizowany w celu uzyskania lepszego BI i praktycznych spostrzeżeń. Przykładami insightów generowanych z VCA są formy wzorców, cech, atrybutów i konkretnych zdarzeń, pozwalające na podejmowanie skutecznych decyzji i sprawne wdrażanie przez właściwe osoby w odpowiednim czasie. Oprócz uzyskiwanych informacji monitorujących, kolejnym ważnym obszarem zastosowania VCA jest automatyczne indeksowanie i wyszukiwanie wideo. Wraz z rozwojem wielu form treści wideo i źródeł indeksowanie nośników treści przeszukiwalnych dla IE ma kluczowe znaczenie. Proces indeksowania odbywa się na podstawie różnych poziomów danych zawartych w filmie, takich jak teksty, audio, metadane i treści wizualne. Różne techniki analityczne można łączyć w celu analizy zawartości do indeksowania; na przykład analiza tekstu może być używana do indeksowania wideo w transkrypcjach i analizy dźwięku w ścieżkach dźwiękowych zawartych w wideo. W architekturze systemowej VCA były dwie główne techniki: serwerowa i brzegowa. W przypadku konfiguracji opartej na serwerze skonfigurowano scentralizowany i dedykowany serwer, aby odbierać wszystkie filmy zarejestrowane przez każdą kamerę. VCA zostały wykonane bezpośrednio na tym serwerze przy użyciu wszystkich odebranych filmów.Głównym aspektem tej konfiguracji jest ograniczenie przepustowości transmisji danych wideo. Aby sprostać temu ograniczeniu, dane wideo ze źródła są często kompresowane. Ta kompresja powoduje utratę informacji w filmie, co wpłynie na dokładność analizy. Jednak konfiguracja oparta na serwerze umożliwia łatwiejszą konserwację i, co najważniejsze, ekonomię skali, przezwyciężając ograniczenia przepustowości. W przeciwieństwie do tego, konfiguracja oparta na krawędziach zapewnia bezpośrednie VCA stosowane lokalnie w systemie obrazowania przy użyciu nieprzetworzonych danych przechwyconych przez kamerę. Taka konfiguracja nie powoduje utraty informacji, ponieważ użyto nieprzetworzonych danych wideo. Cała zawartość wideo jest dostępna do analizy, co przyczynia się do zwiększenia dokładności analizy. Jednak koszty konfiguracji i konserwacji są wyższe w przypadku tej konfiguracji, a wydajność przetwarzania systemu jest również niższa w porównaniu z systemami opartymi na serwerze.

Analiza wideo

Postęp technologii komputerowych i obrazowania cyfrowego napędza wdrożenie analizy treści wideo (VCA) w celu uzyskania ważnych informacji z treści wideo. Wraz ze zwiększoną mocą obliczeniową można wdrożyć VCA w celu niemal natychmiastowego generowania znaczących informacji i spostrzeżeń. Nowoczesne zakłady produkcyjne wyposażone w dużą liczbę systemów CCTV i kamer do monitorowania procesów produkcyjnych, stanu urządzeń i przepływów materiałów na hali produkcyjnej. Dzięki takim urządzeniom do obrazowania, kontrolerzy produkcji będą mogli monitorować wszystkie ważne procesy w scentralizowanej sterowni. Dysk BD wygenerowany z kanałów wideo może być dalej analizowany w celu uzyskania lepszego BI i praktycznych spostrzeżeń. Przykładami insightów generowanych z VCA są formy wzorców, cech, atrybutów i konkretnych zdarzeń, pozwalające na podejmowanie skutecznych decyzji i sprawne wdrażanie przez właściwe osoby we właściwym czasie. Oprócz uzyskiwanych informacji monitorujących, kolejnym ważnym obszarem zastosowania VCA jest automatyczne indeksowanie i wyszukiwanie wideo. Wraz z rozwojem wielu form treści wideo i źródeł indeksowanie nośników treści przeszukiwalnych dla IE ma kluczowe znaczenie. Proces indeksowania odbywa się na podstawie różnych poziomów danych zawartych w filmie, takich jak teksty, audio, metadane i treści wizualne. Różne techniki analityczne można łączyć w celu analizy zawartości do indeksowania; na przykład analiza tekstu może być używana do indeksowania wideo w transkrypcjach i analizy dźwięku w ścieżkach dźwiękowych zawartych w wideo. W architekturze systemowej VCA były dwie główne techniki: serwerowa i brzegowa. W przypadku konfiguracji opartej na serwerze skonfigurowano scentralizowany i dedykowany serwer, aby odbierać wszystkie filmy zarejestrowane przez każdą kamerę. VCA zostały wykonane bezpośrednio na tym serwerze przy użyciu wszystkich odebranych filmów.Głównym aspektem tej konfiguracji jest ograniczenie przepustowości transmisji danych wideo. Aby sprostać temu ograniczeniu, dane wideo ze źródła są często kompresowane. Ta kompresja powoduje utratę informacji w filmie, co wpłynie na dokładność analizy. Jednak konfiguracja oparta na serwerze umożliwia łatwiejszą konserwację i, co najważniejsze, ekonomię skali, przezwyciężając ograniczenia przepustowości. W przeciwieństwie do tego, konfiguracja oparta na krawędziach zapewnia bezpośrednie VCA stosowane lokalnie w systemie obrazowania przy użyciu nieprzetworzonych danych przechwyconych przez kamerę. Taka konfiguracja nie powoduje utraty informacji, ponieważ użyto nieprzetworzonych danych wideo. Cała zawartość wideo jest dostępna do analizy, co przyczynia się do zwiększenia dokładności analizy. Jednak koszty konfiguracji i konserwacji są wyższe w przypadku tej konfiguracji, a wydajność przetwarzania systemu jest również niższa w porównaniu z systemami opartymi na serwerze.

Analityka społeczna